今天要來跟大家介紹一個名為【video-retalking】的開源專案,這個專案可以讓我們將輸入影片中的人物說話嘴型,改成配合輸入的音檔。是個非常有趣的專案。

這個專案在本周也出現在了 GitHub 的 Trending 頁面,代表它有一定的關注度。

並且這個專案在他給出的範例中,表現也算是相當的良好。以下大家可以看看官方提供的範例。

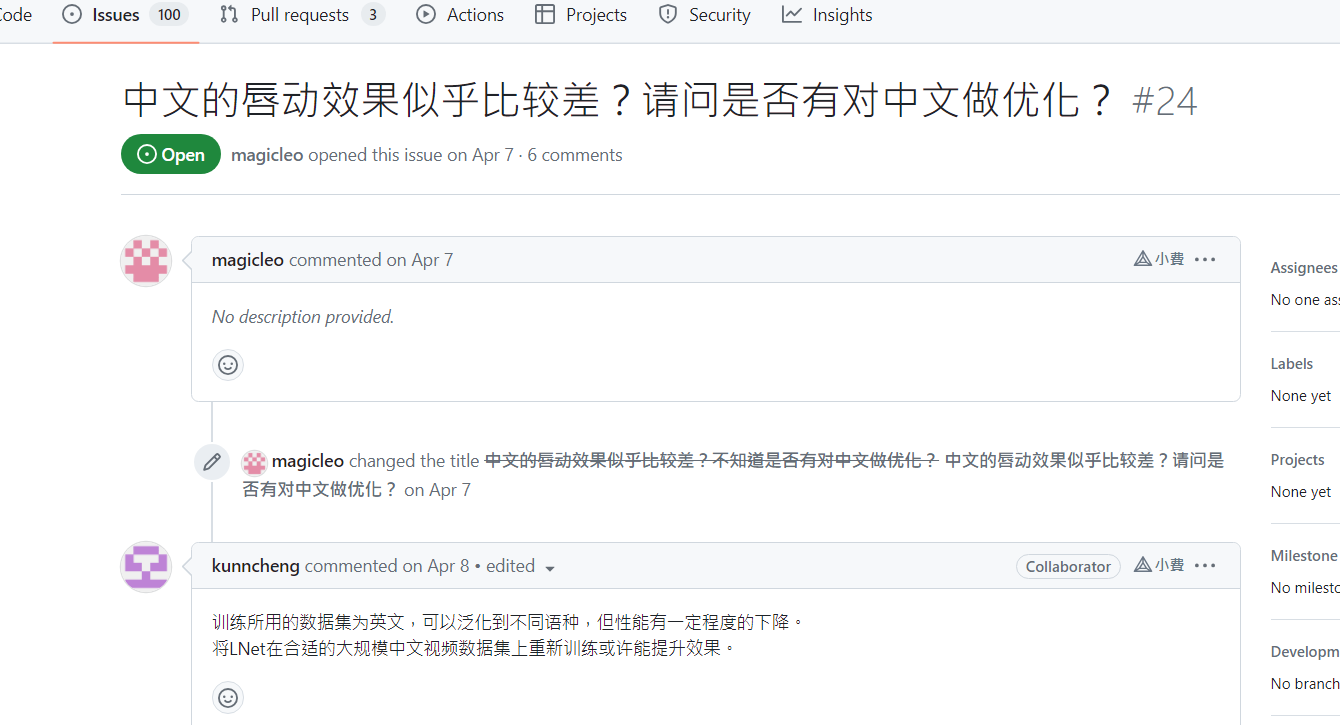

然後雖然有人反映輸入中文語音的表現效果可能不是這麼好,但我自己測試的結果是依然還算不錯。最後會再給大家看看合成效果。

警告! — 這個專案很適合用來詐騙

看到今天的這個專案,許多人應該都能想到,這個專案搭配 Vits 這類可以複製其他人聲音的語音合成技術,非常適合拿來詐騙或散布假消息。

雖然因為專案本身是開源的,根本不可能防止有心人利用這個專案。所以只譨提醒大家未來要提高警覺,因為現在不只有效果非常好的聲音複製技術,也有很簡單就能讓影片對嘴型的技術,影片的真實性將愈來愈難查證。

【VITS-fast-fine-tuning】自己製作一個VITS語音合成模型:

https://www.youtube.com/watch?v=riYOD_EFKDE

專案使用

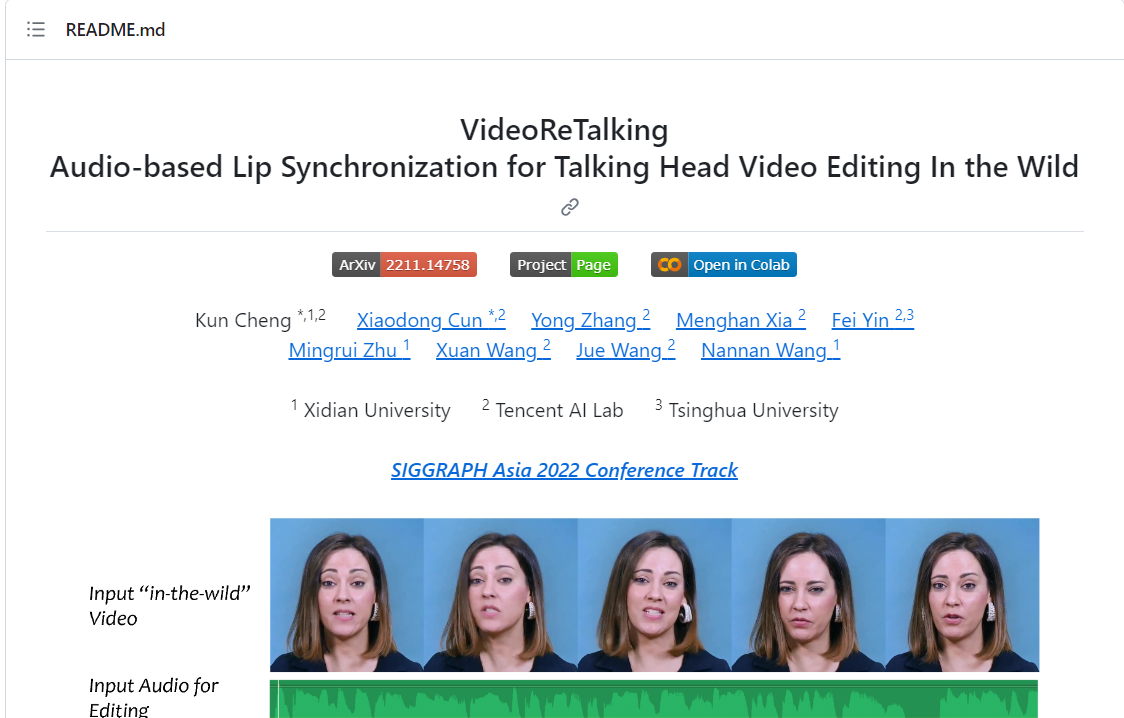

以下是 video-retalking 的專案連結,在點進去後,我們可以選擇是要將專案下載下來在自己電腦上跑,或是使用 Colab 來執行。

video-retalking GitHub 頁面:

https://github.com/OpenTalker/video-retalking

但這邊要注意一下,video-retalking 的 VRAM 需求稍高,可能會吃超過 12GB 的 VRAM,所以如果顯卡 VRAM 不夠多,建議可以直接用 Colab 來玩玩看。今天的測試我也會使用 Colab 來做。

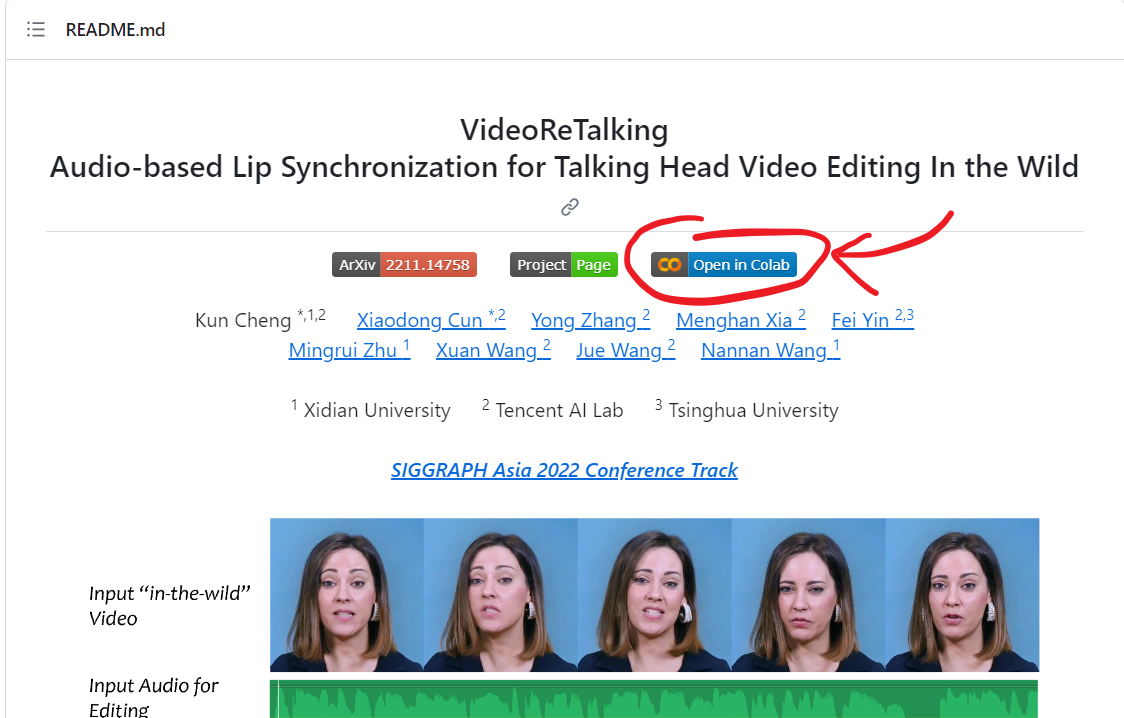

要使用 Colab 來執行 video-retalking 的話,這邊官方有提供一個 Colab 記事本,我們可以在 README 文件的最上方找到記事本的連結。

或者你也可以點以下連結來開啟 video-retalking 的 Colab 記事本

Colab 記事本連結:

https://colab.research.google.com/github/vinthony/video-retalking/blob/main/quick_demo.ipynb

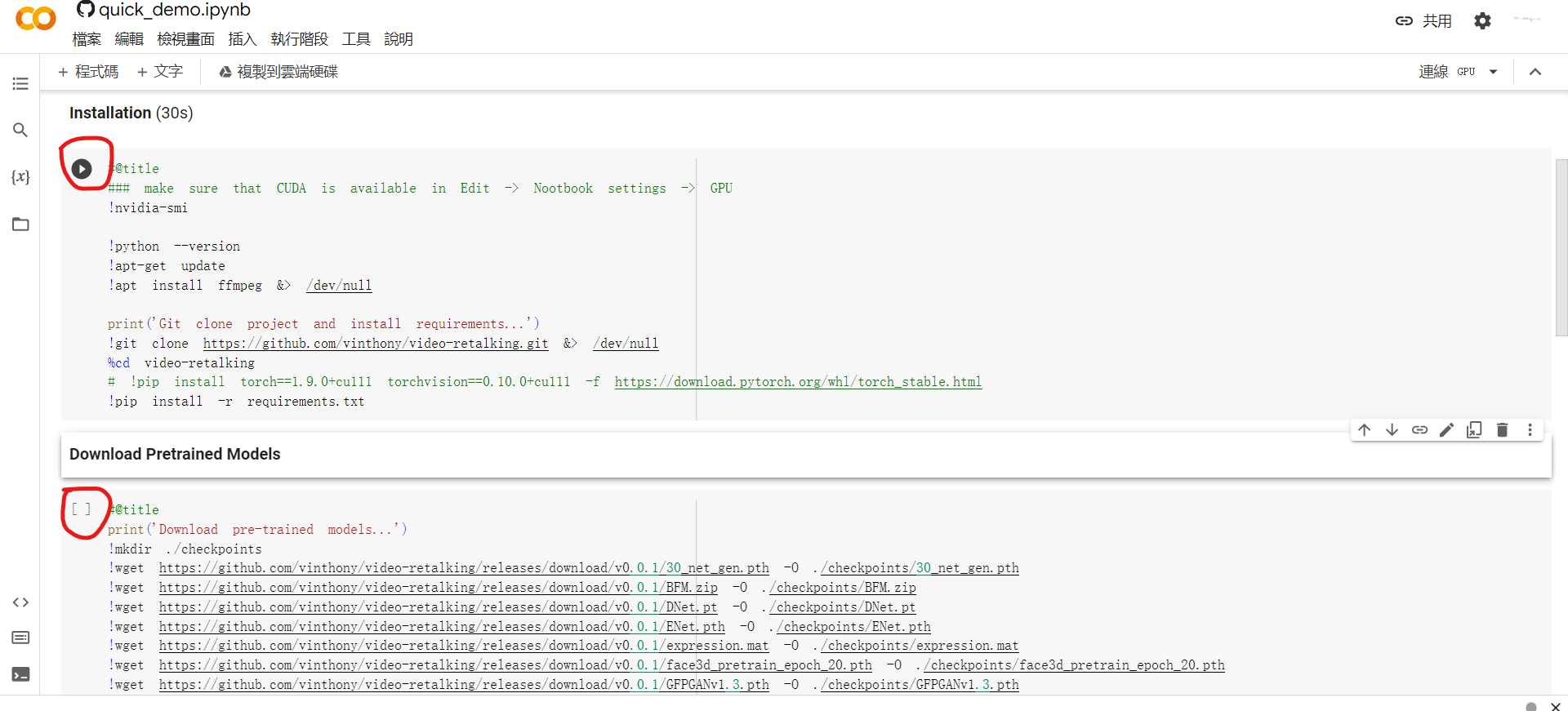

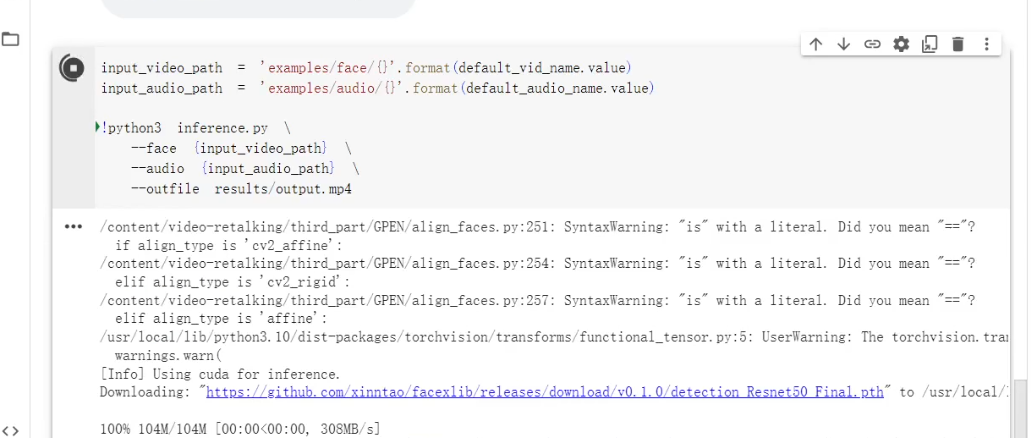

在開啟 Colab 記事本後,我們需要先執行 Installation 以及 Download Pretrained Models 這兩個程式碼區塊。讓 Colab 把專案複製下來安裝需要的函式庫,並下載 Pretrained Models。

等到這兩個區塊跑完後,我們就可以來選擇要使用的檔案了。

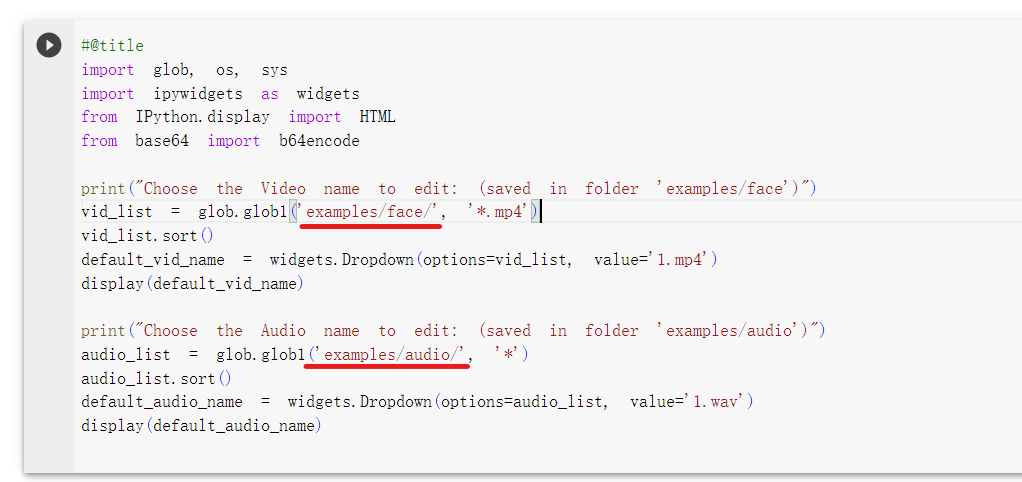

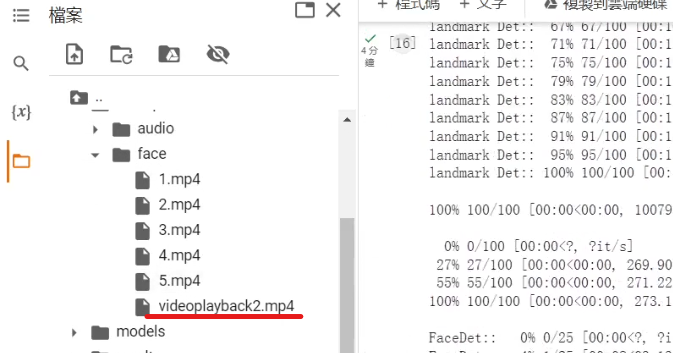

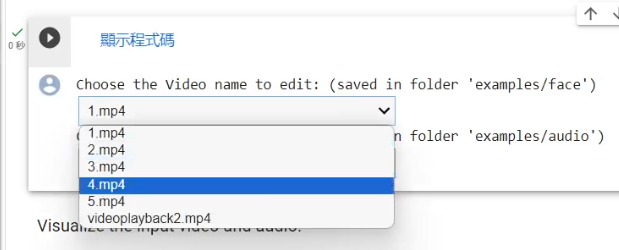

我們看到 Inference 下方的第 1 個程式碼區塊,將程式碼展開,可以看到檔案是放在 examples/face 以及 examples/audio 裡。執行這個區塊後,會生成選擇器,讓我們選擇這兩個資料夾內的檔案。

所以如果想要使用自己的檔案,可以將檔案上傳後,分別移到這兩個資料夾內。再執行這個區塊

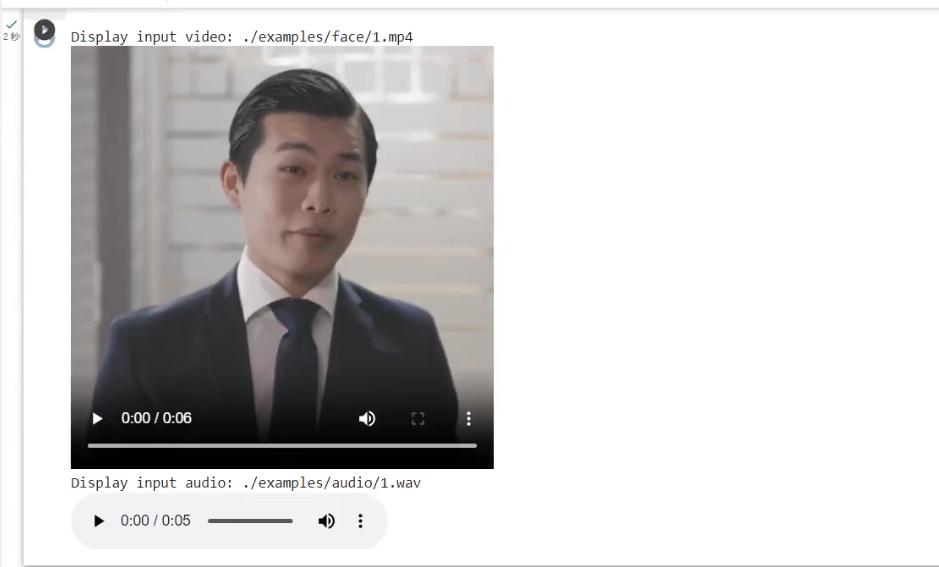

選完檔案後我們可以執行一下下方 Visualize the input video and audio 區塊,檢查輸入檔案是否正確

檢查完確認無誤後,我們就可以執行下一個程式碼區塊,讓 AI 開始計算。

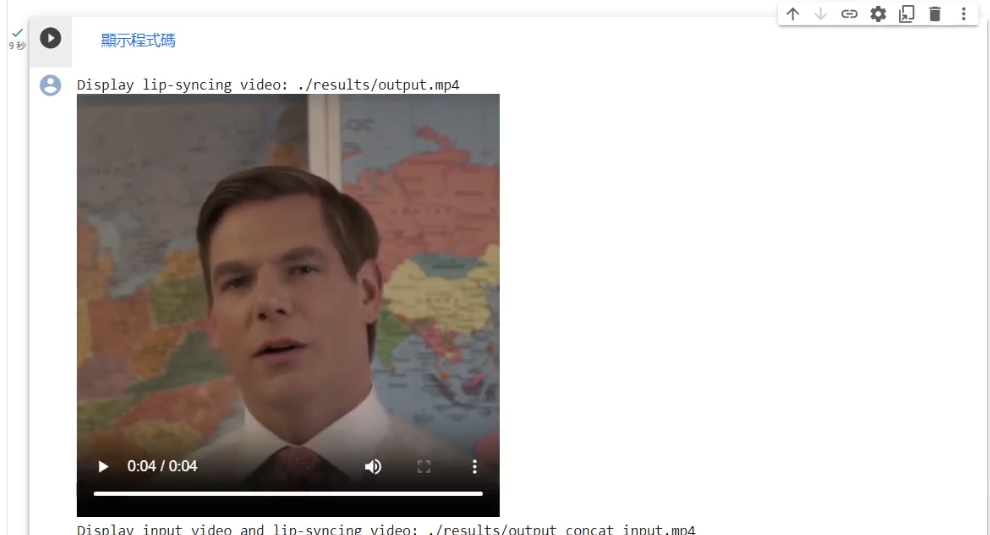

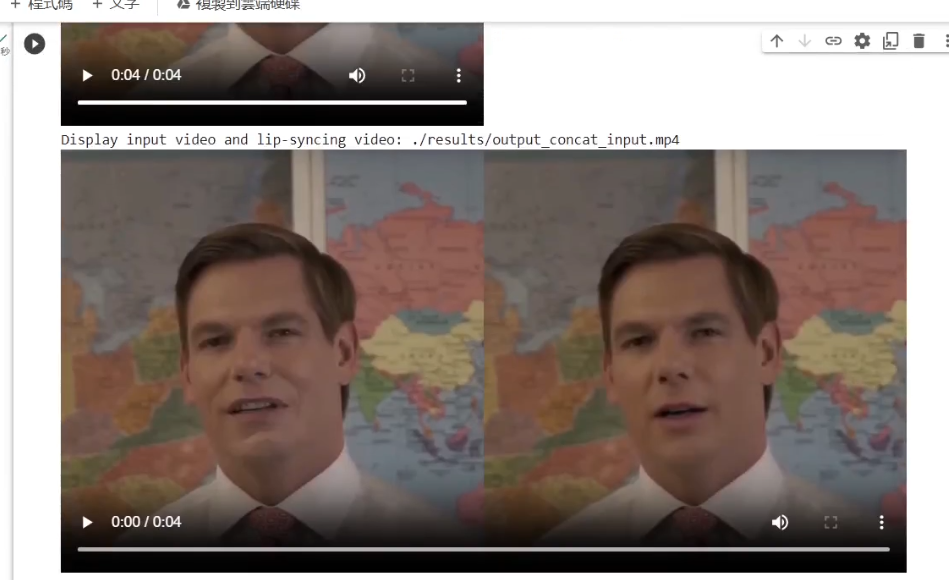

等到執行完後,就可以執行最後的 Visualize the output video 區塊,查看生成的結果。這邊他的生成結果回有兩個,一個是單純的輸出檔案,另一個是原始影片與生成影片的比較。

最後就來看一下 AI 對嘴型的效果如何