前天,許久未見的 ControlNet 作者 Lvmin Zhang 大神再次震撼開源界,推出了一個名為 FramePack 的新專案。

專案不只能夠生成結果流暢、自然的影片,最驚人的地方在於,它能夠一次生成長達60秒的AI影片,而且最低只需要 6GB VRAM 的顯卡就能運行!這對於許多硬體條件有限的創作者來說無疑是一大福音, 今天就來跟大家介紹一下。

一些官方demo影片

FramePack 是什麼?解決了哪些痛點?

FramePack 主要功能是實現 AI 圖片轉影片,而且是能夠一次生成長達 60 秒的 AI 影片。雖然其底層生成模型使用了騰訊的「混元」,但 Lvmin Zhang 大神與 Stanford 的 Maneesh Agrawala 教授共同研發的 FramePack 架構,才是實現長影片生成的關鍵。

根據他們的論文所述,FramePack 主要解決了 AI 生成長影片時常見的兩大問題:

- 模型遺忘 (Forgetting): 模型隨著時間推移,難以記住影片早期的內容。例如,鏡頭轉了180度,幾秒後再轉回來,畫面可能變得跟之前完全不同。

- 模型飄移 (Drifting): 生成過程中產生的微小錯誤不斷累積,導致影片越到後面品質越差,內容逐漸偏離原始主題。

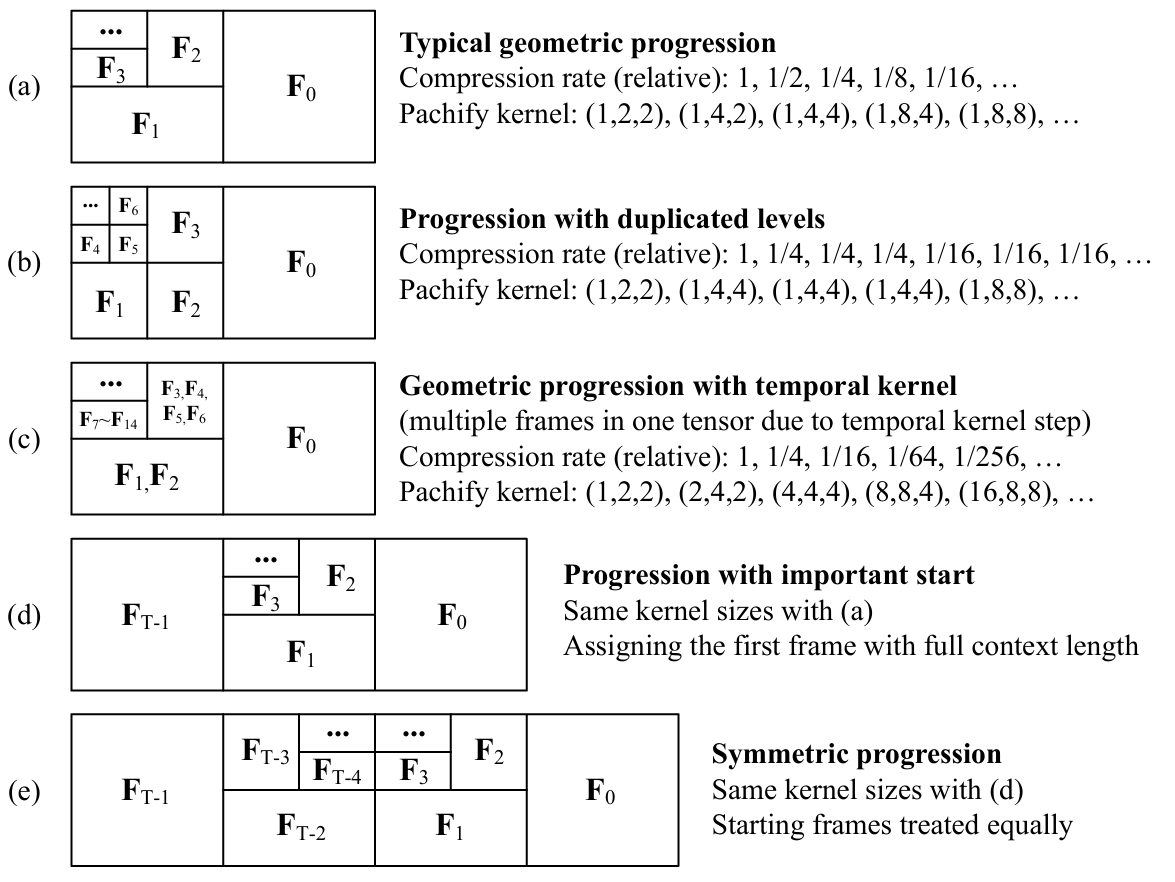

FramePack 的解決方案是對輸入幀進行漸進式壓縮 (Progressive Compression)。它會對相對不重要的幀進行壓縮,且會對不同重要性的幀應用不同的壓縮率:時間上越接近下一幀的歷史幀越重要,壓縮率越低;距離越遠的幀則越不重要,壓縮率越高。透過這種機制,可以將輸入的總Token數量控制在一個上限,既能記住足夠長的歷史內容,又能有效節省 VRAM 和計算資源。

詳細的論文內容這邊就不贅述。有興趣深入研究的觀眾,可以在 FramePack 的 GitHub Repository 找到論文連結, 或直接點擊下方的連結進到 arXiv 查看。

如何安裝與使用 FramePack? (Windows 整合包)

Lvmin Zhang 大神非常貼心地提供了整合包,讓 Windows + NVIDIA 顯卡的用戶可以一鍵啟動,省去繁瑣的環境配置。

硬體需求與系統要求

FramePack 的硬體門檻相當親民:

- 顯卡: NVIDIA 30、40、50 系列顯卡 (需支援 FP16/BF16),20與10系的顯卡作者沒測試過,不確定效果。

- VRAM: 至少 6GB

- 系統: Windows 或 Linux

- 記憶體: 建議至少 32GB

這意味著許多近幾年的遊戲筆電也有機會運行 FramePack,只是生成速度可能會比較慢。

另外需注意,整合包下載完開啟後會額外下載約 40GB 的模型文件,所以請確保你的硬碟空間足夠。

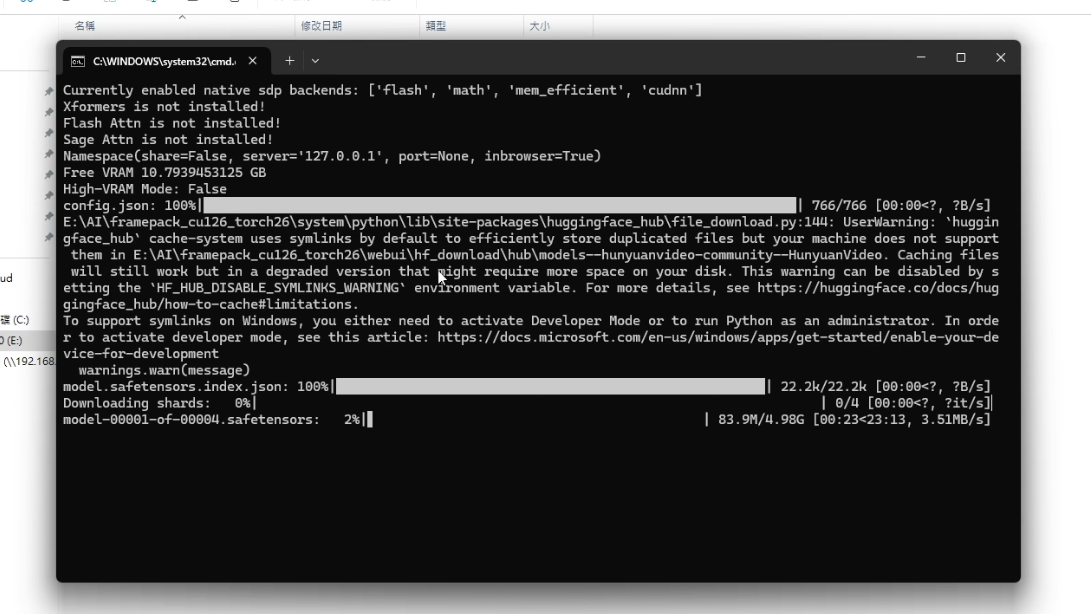

操作步驟

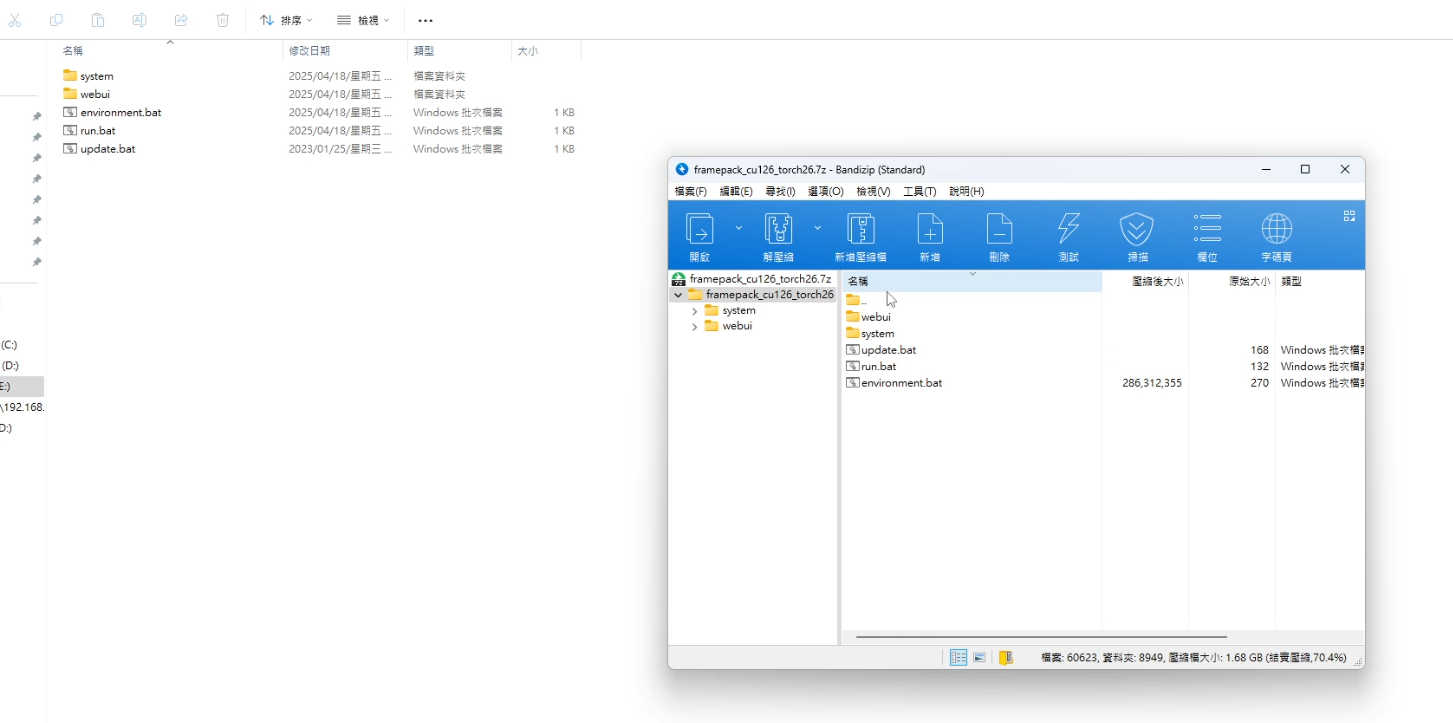

- 下載整合包: 前往 FramePack GitHub 頁面 頁面,找到整合包的下載連結並下載。

- 解壓縮: 將下載的檔案解壓縮到你想要的位置。

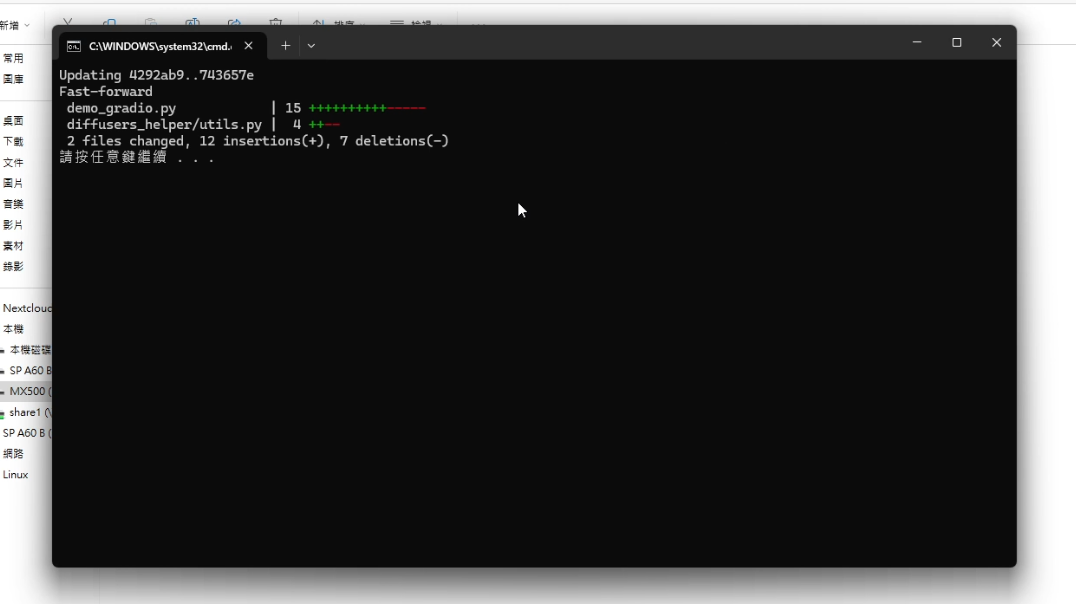

- 更新: 執行資料夾內的

update.bat批次檔,等待更新完成。

-

運行: 執行

run.bat批次檔。- 首次運行: 會自動下載所需的模型(基於混元的變體和 FramePack 模型),這會佔用不少硬碟空間,請確保容量充足。

-

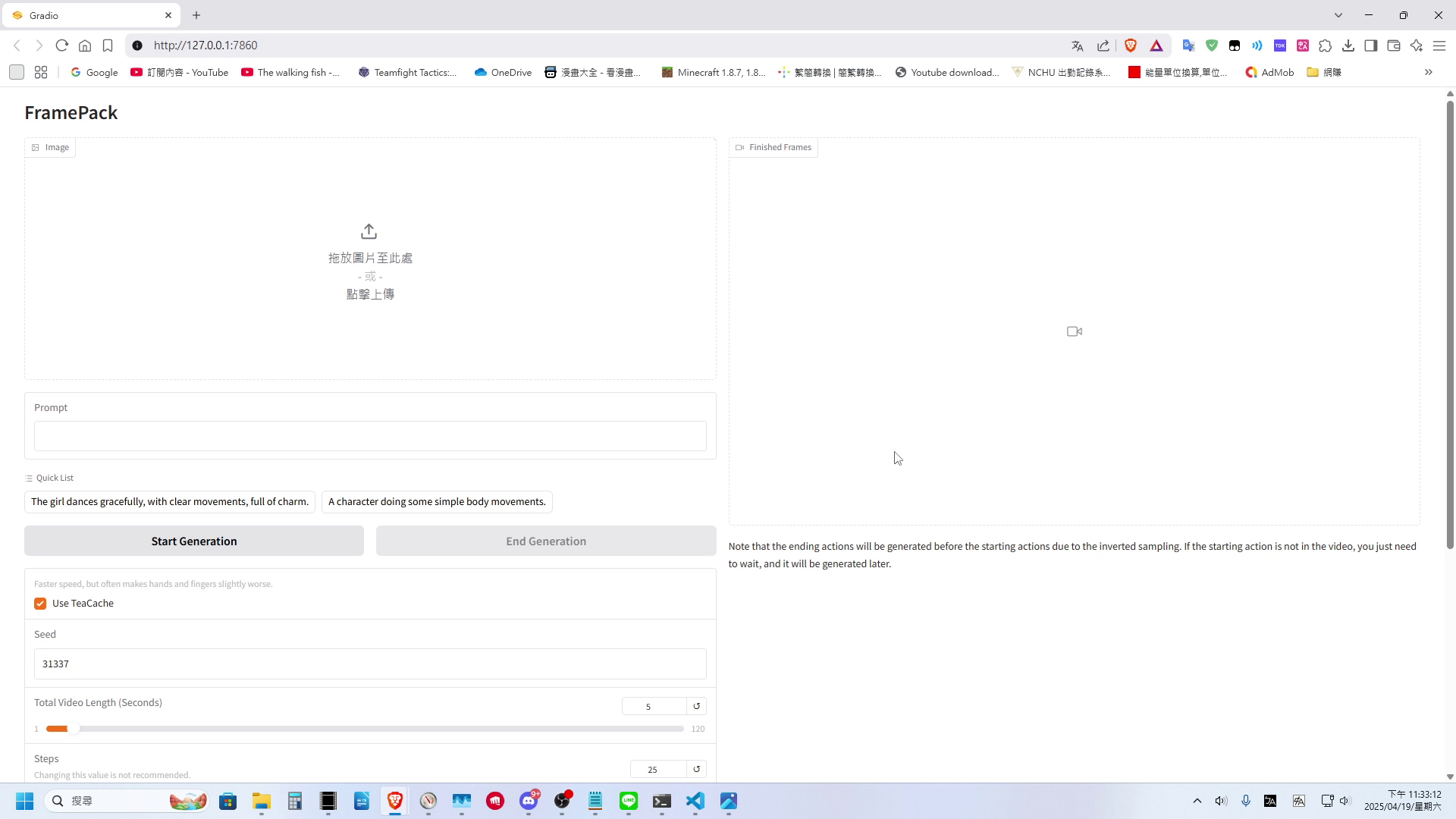

開啟 WebUI: 模型下載完成後,會自動在瀏覽器開啟 WebUI 操作介面。

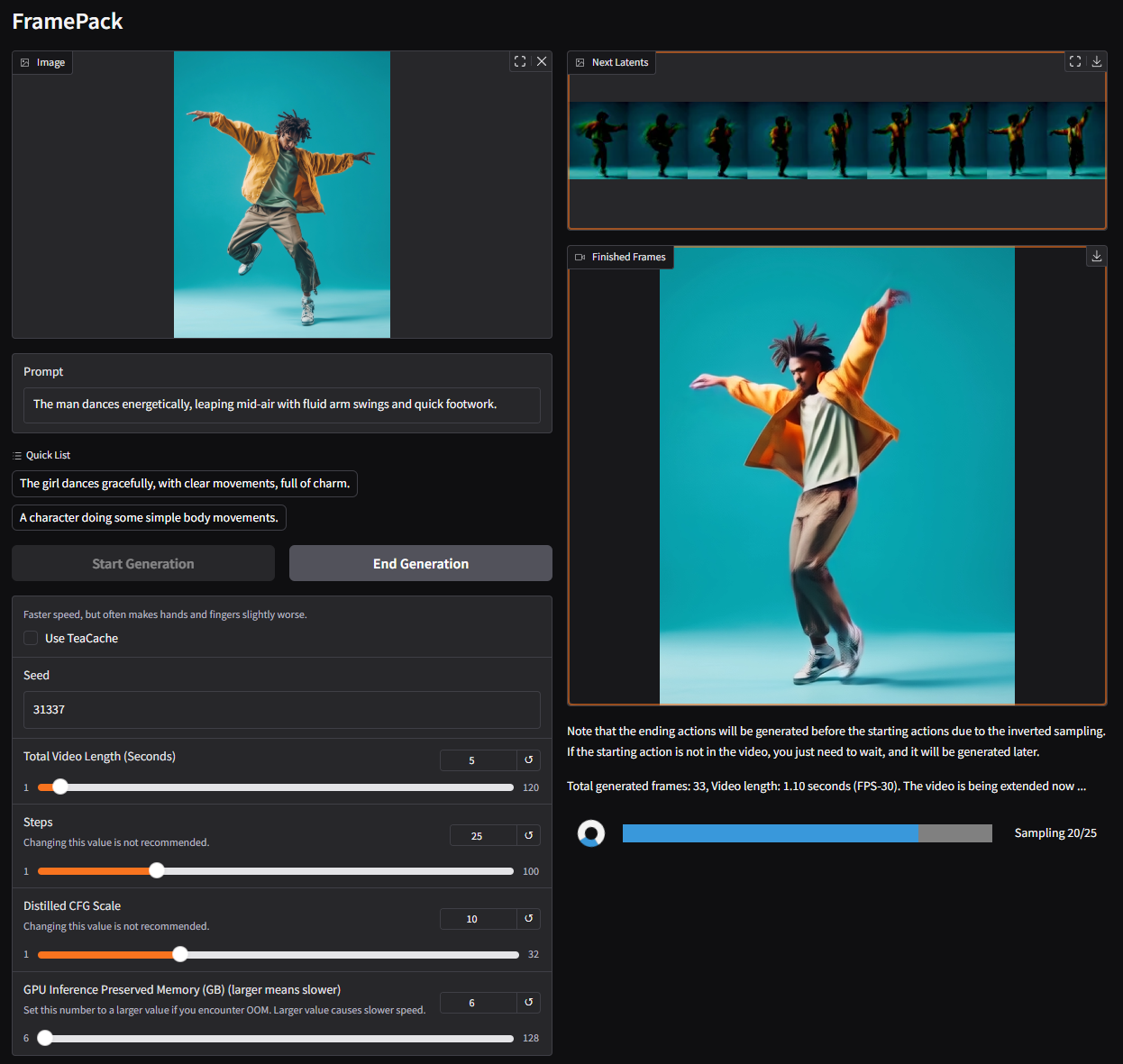

使用 FramePack 生成影片

FramePack 的 WebUI 操作相對直觀:

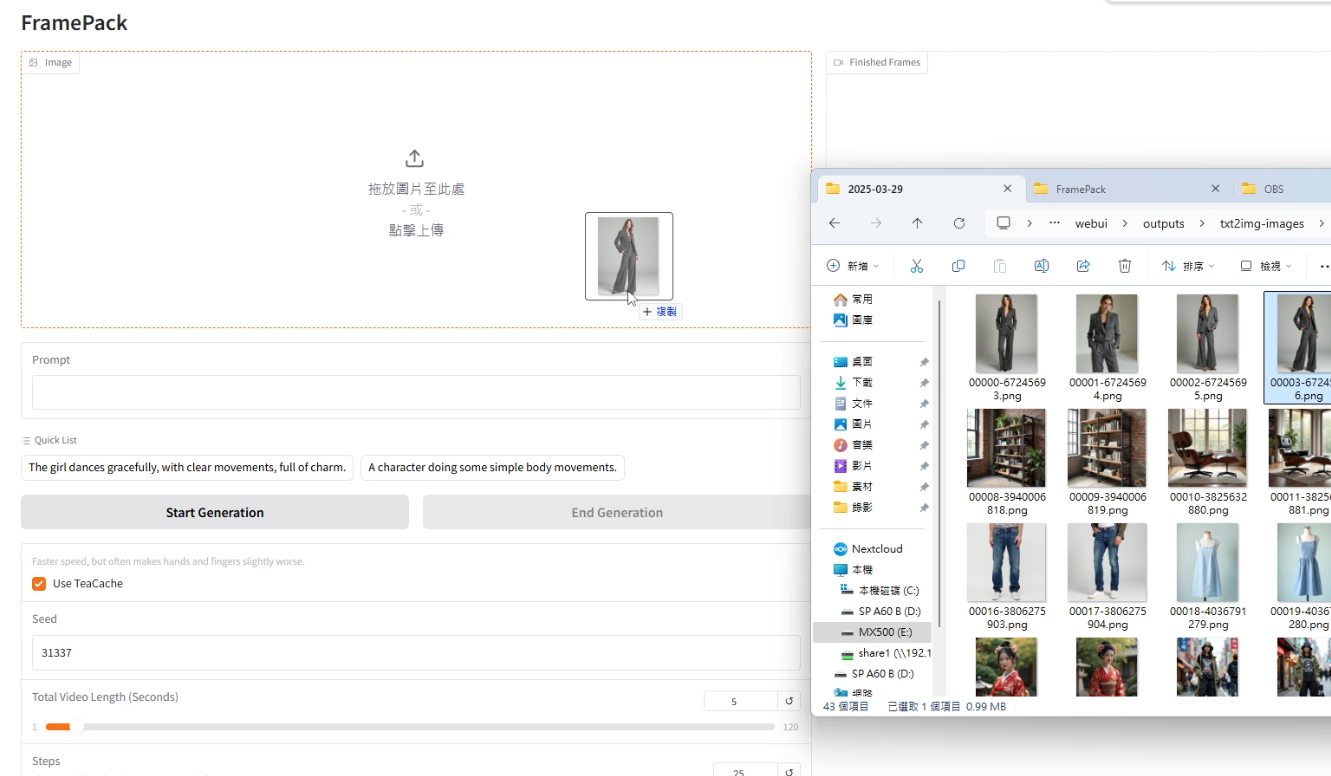

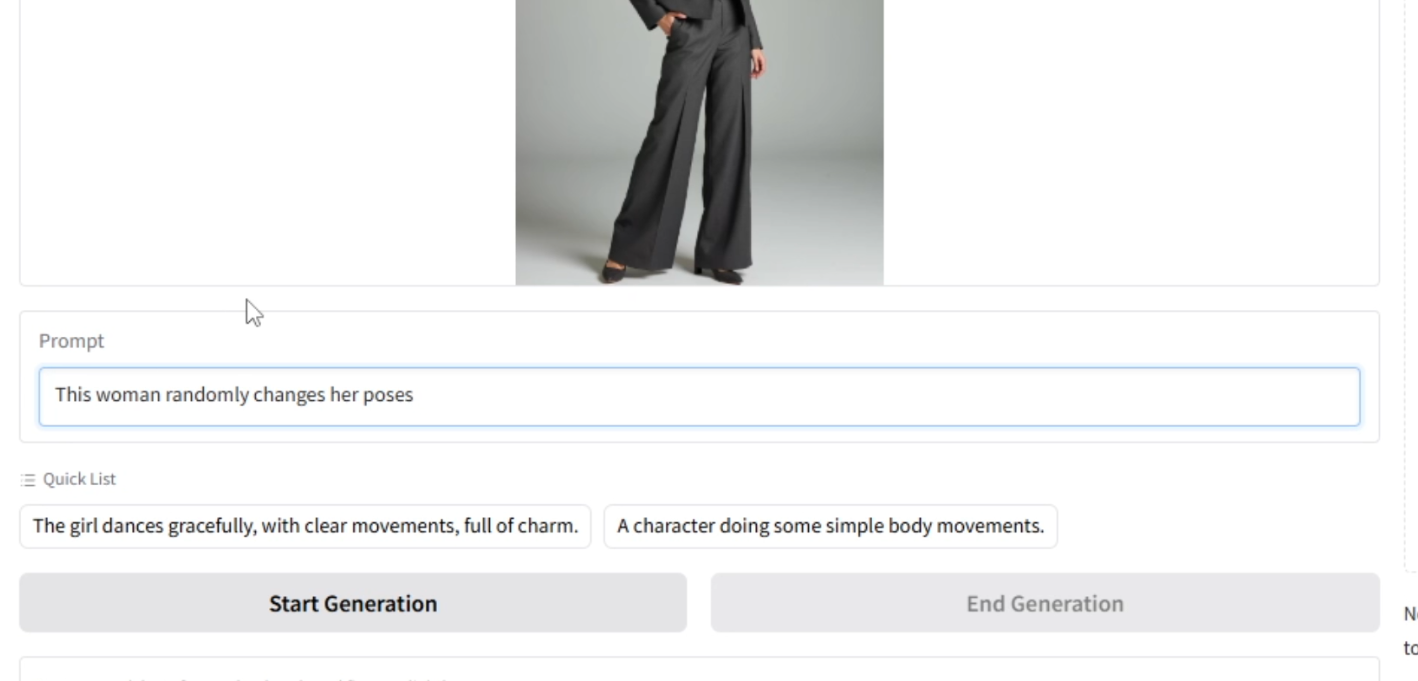

- 輸入參考圖片: 上傳一張你想要讓它動起來的起始圖片(例如 AI 生成的模特兒圖片)。

-

輸入動作提示詞 (Prompt): 在下方的文字框中,輸入描述畫面接下來如何運動的提示詞。例如,輸入「隨機改變 Pose」。

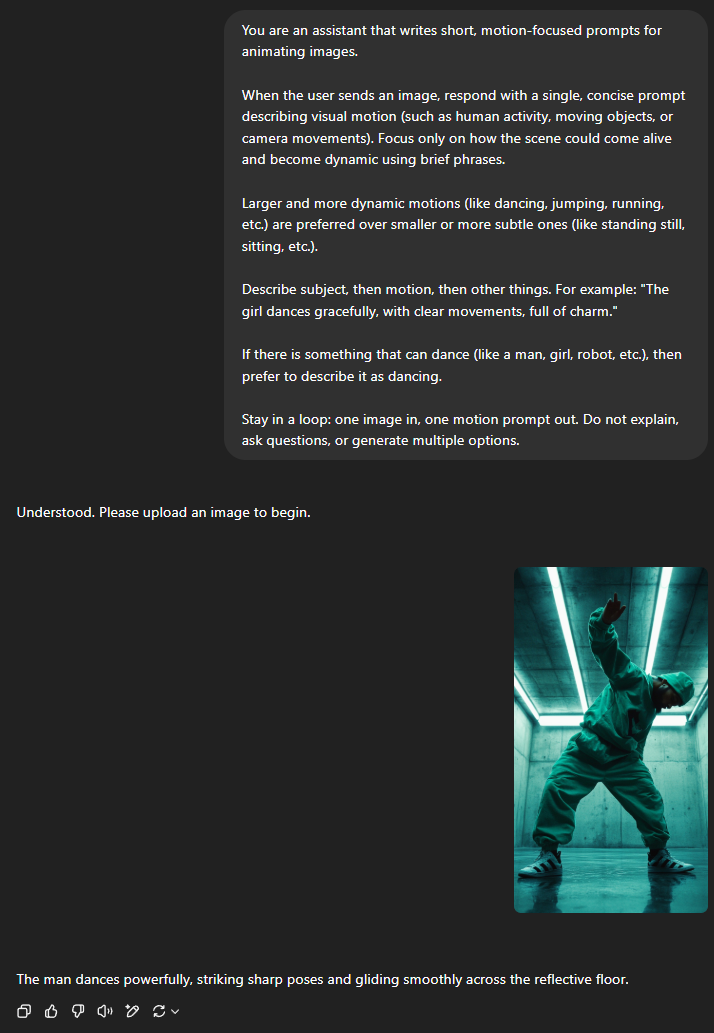

提示詞小技巧: 如果不知道怎麼寫,可以參考 FramePack Readme 文件底部的 ChatGPT 提示詞(也可以直接複製下面的),將其複製到 ChatGPT 或 Gemini 送出,再貼給他圖片,它就能生成適用於 FramePack 的動作提示詞。

1 2 3 4 5 6 7 8 9 10 11You are an assistant that writes short, motion-focused prompts for animating images. When the user sends an image, respond with a single, concise prompt describing visual motion (such as human activity, moving objects, or camera movements). Focus only on how the scene could come alive and become dynamic using brief phrases. Larger and more dynamic motions (like dancing, jumping, running, etc.) are preferred over smaller or more subtle ones (like standing still, sitting, etc.). Describe subject, then motion, then other things. For example: "The girl dances gracefully, with clear movements, full of charm." If there is something that can dance (like a man, girl, robot, etc.), then prefer to describe it as dancing. Stay in a loop: one image in, one motion prompt out. Do not explain, ask questions, or generate multiple options. -

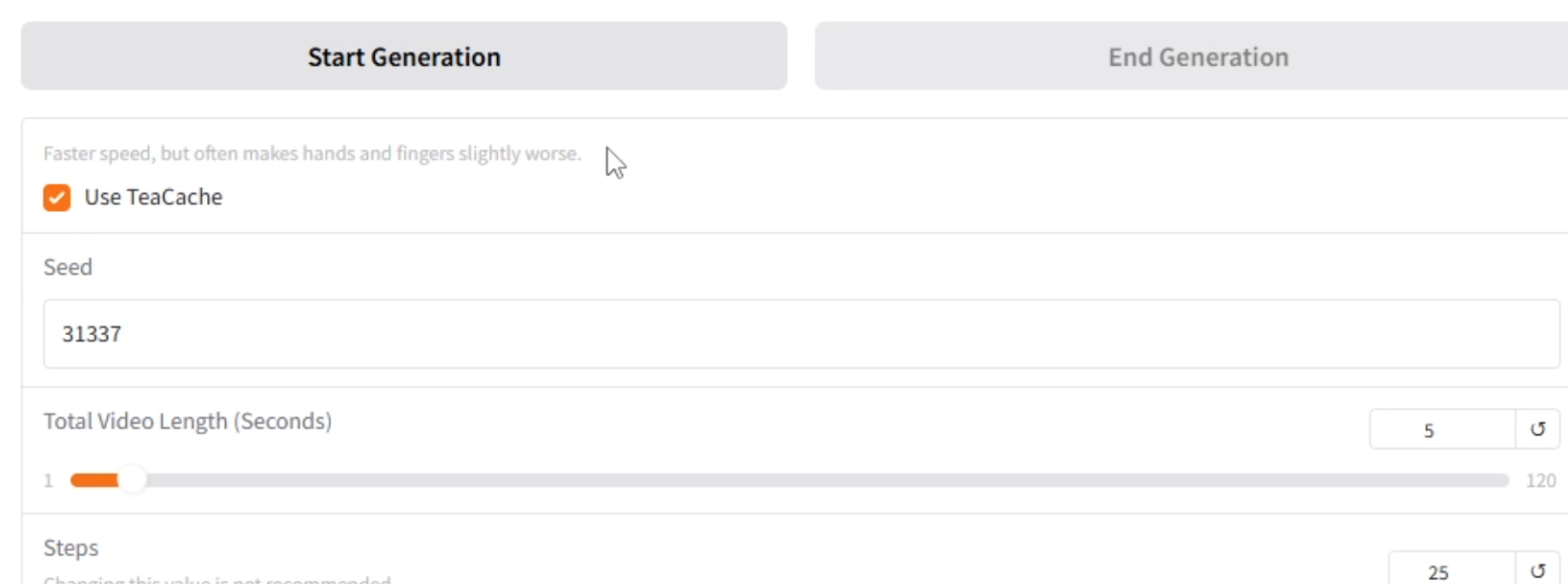

設定選項:

- TeaCache: 預設勾選。大幅提升生成速度,但會降低影像品質,尤其在動作幅度較大時可能出現模糊或扭曲(例如手部)。作者建議可以先開啟 TeaCache 快速預覽效果,滿意大致方向後,再關閉 TeaCache 生成最終成品。

- SEED: 隨機種子,控制生成結果的隨機性。固定 SEED 和輸入可以得到相同的輸出。可以嘗試調整此數值來獲得不同效果。

- 影片時長 (Seconds): 設定想要生成的影片長度(最高支援 60 秒)。

- 生成: 點擊「Start Generation」按鈕開始生成。

生成速度與效果實測

根據影片中的測試(硬體:Intel i5-14400F + NVIDIA RTX 4070 Super 12GB):

- 開啟 TeaCache: 生成 1 秒影片約需 3 分鐘。

- 關閉 TeaCache: 生成 1 秒影片約需 5~6 分鐘 (約 2 倍時間)。

雖然速度不算飛快,但考量到是在本地端運行且 VRAM 需求低,算是可以接受的範圍。生成 60 秒的影片需要相當長的時間,我設定完按下生成,去了一趟 Costco 後回家,他都還沒生成完。

效果方面:

人物的動作、衣服擺動等細節處理得相當細緻和真實。對於非人類主體(如貓、跑車)和非寫實風格圖片也能生成不錯的效果。特寫畫面中的手部細節處理也尚可。但在開啟 TeaCache 時,快速或大幅度的動作容易模糊。如同目前多數影片生成模型,有時會出現不太符合物理常識的畫面,例如杯子飄起來之類的,但這算式這類模型目前的通病。

生成的影片檔案會存放在專案目錄下的 webui/outputs 資料夾中。

生成結果展示

以下展示一些使用 FramePack 生成的範例效果(全部都是開啟 TeaCache 的狀態):

-

AI 模特兒隨機 Pose 變化:

可以看到動作流暢,衣服的擺動相當自然流暢。 -

紅禮服女士跳舞:

手部快速揮動時出現模糊,但整體動態尚可。 -

貓咪睡覺 (背景火爐):

非人類主體也能處理,背景的火焰很逼真。 -

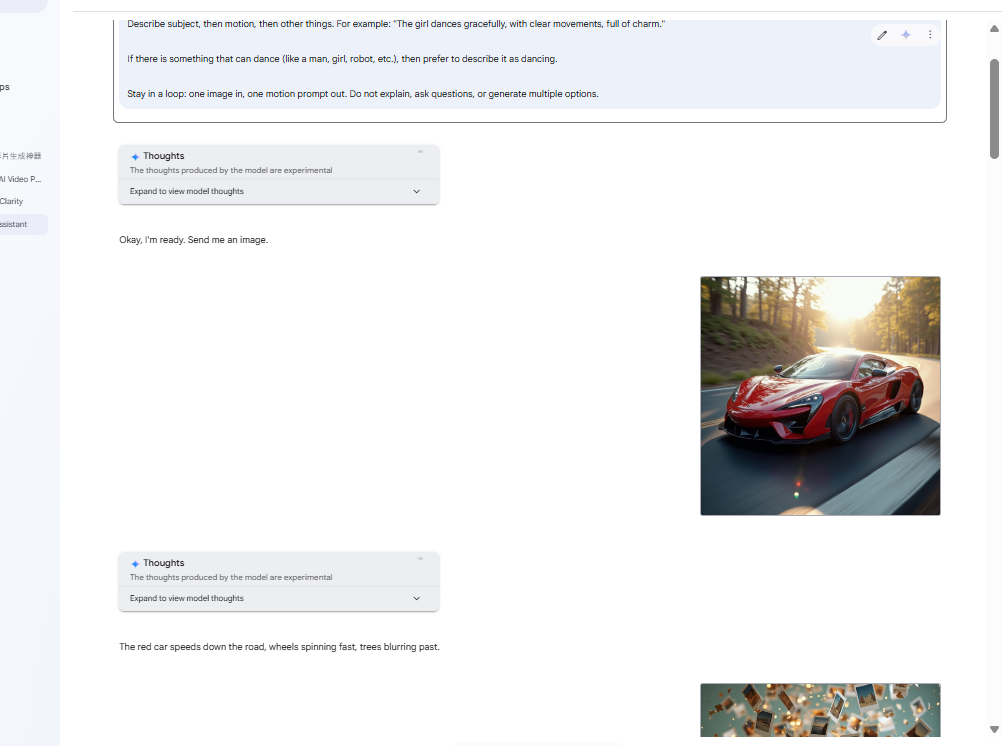

跑車行駛:

動態效果呈現,但有點車子在滑行的感覺。 -

非寫實風格圖片動畫化:

也能應用於不同藝術風格。 -

手部特寫寫字:

如果是特寫手部,那即便開啟 TeaCache 也一樣還是可以有不錯的效果

其他生成結果展示

除以上幾個例子外,我還有用 FramePack 生成一些影片,整體來說就是開啟 TeaCache 時,手部動作較大就很容易崩壞。而關閉 TeaCache,生成的等待時間是真的有點久。

總結

FramePack 無疑是 AI 影片生成領域又一個令人興奮的開源專案。它不僅將生成時長推向了 60 秒,更將硬體門檻降低到了僅需 6GB VRAM,讓更多人有機會在自己的電腦上體驗高品質的 AI 影片創作。雖然生成速度和部分效果細節仍有進步空間,但其創新的 FramePack 架構和易用的整合包,都展現了 Lvmin Zhang 大神一貫的技術實力和對社群的貢獻精神。

如果你對 AI 影片生成感興趣,且符合硬體需求,強烈建議下載 FramePack 來玩玩看!