近期 OpenAI 再次突破人工智慧的界限,正式發表 GPT-4o 多模態大型語言模型。GPT-4o 的 “o” 代表 “omni”,意味著它擁有更全面的多模態能力,可接受文字、語音、影像和視訊的任意組合作為輸入,輸出也可以是任意組合的文字、語音和影像內容,大幅提升了人機互動的自然程度。

並且在發佈會上,OpenAI 更是展示了 GPT-4o 強大的即時對話能力,能夠非常迅速的通過語音與使用者對話,對話的語音也非常的生動、自然、有節奏,甚至還能夠透過鏡頭來真測使用者的穿著、所在的環境等。以下就讓我們來跟大家介紹一下 GPT-4o。

GPT-4o 表現

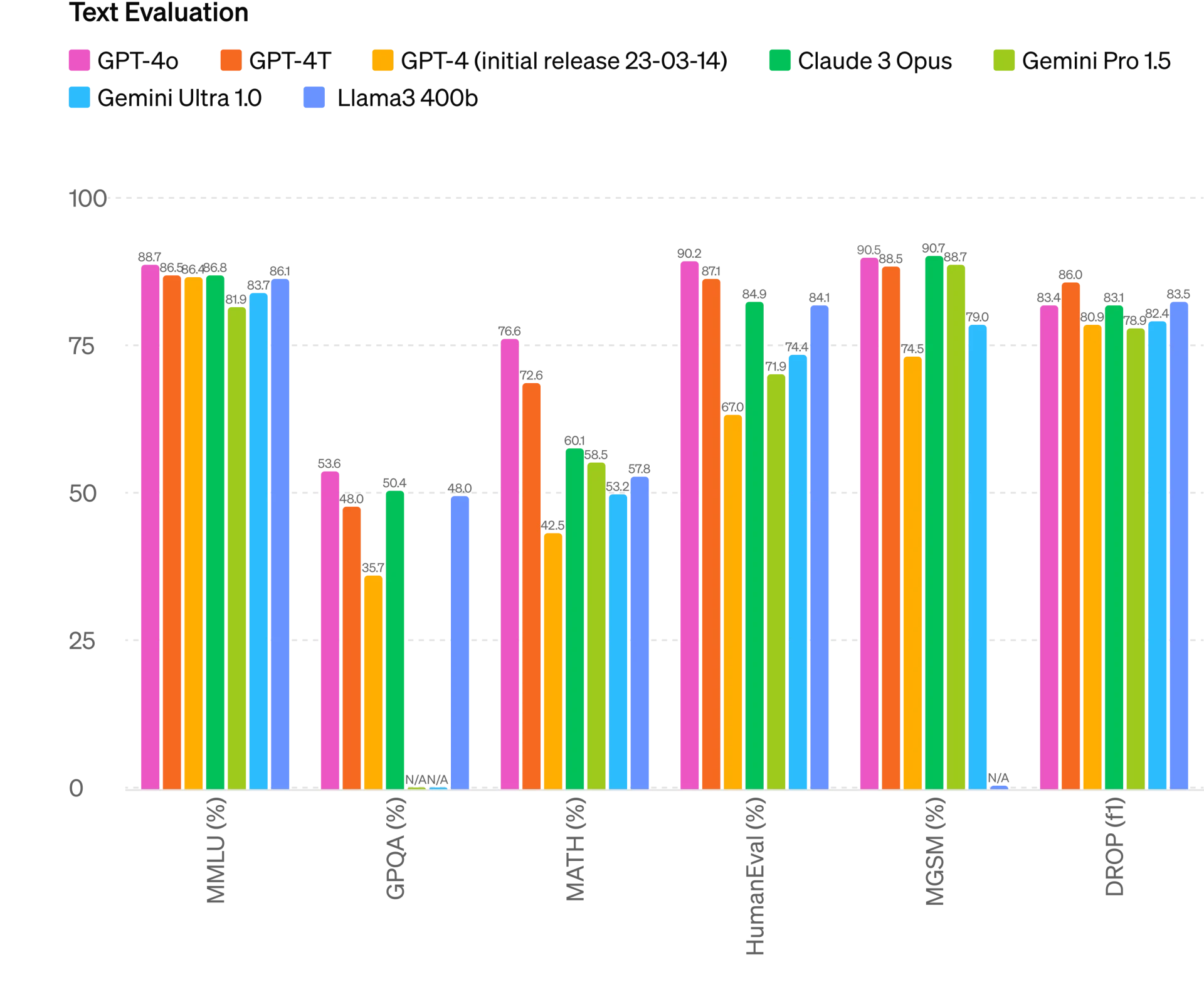

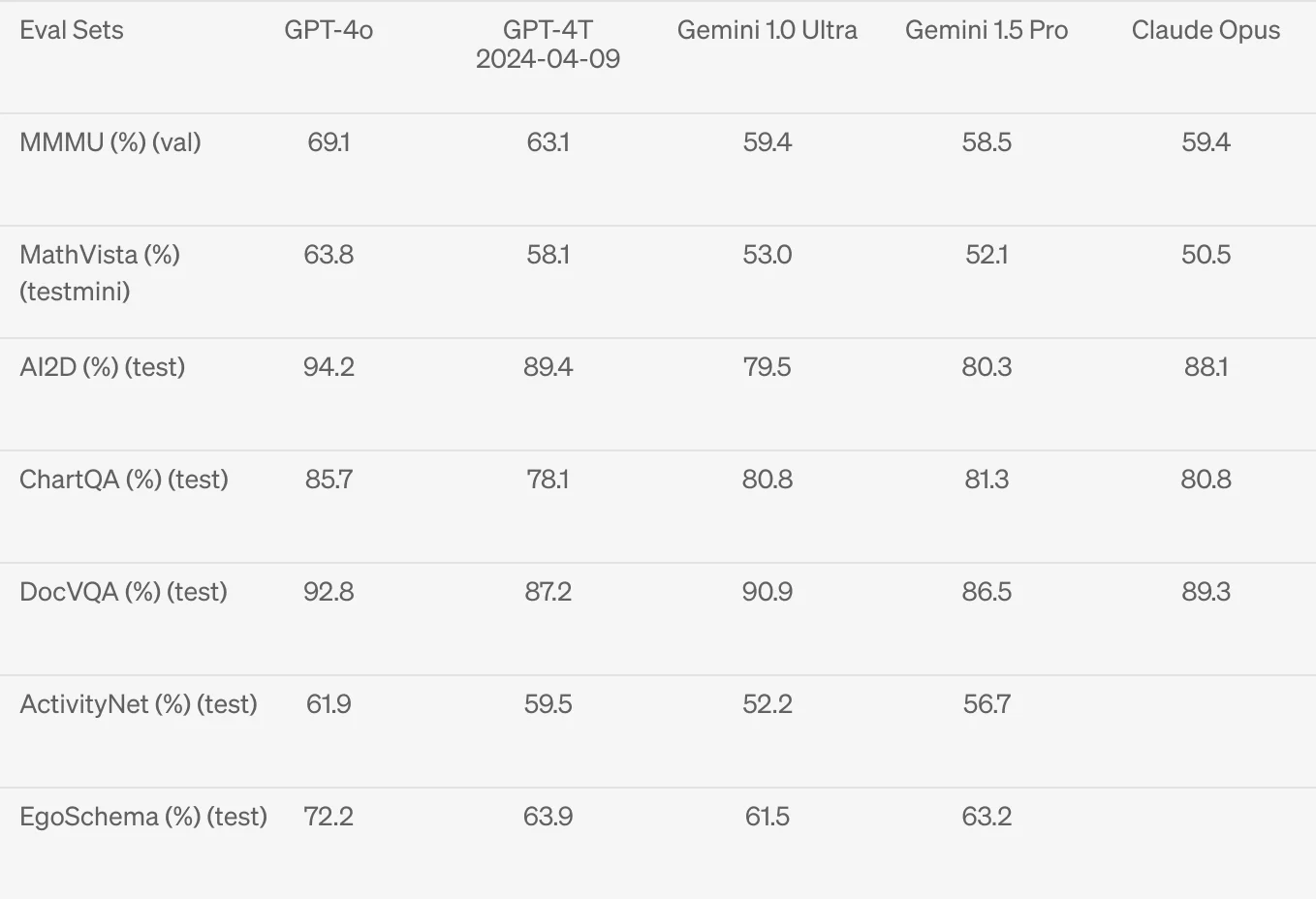

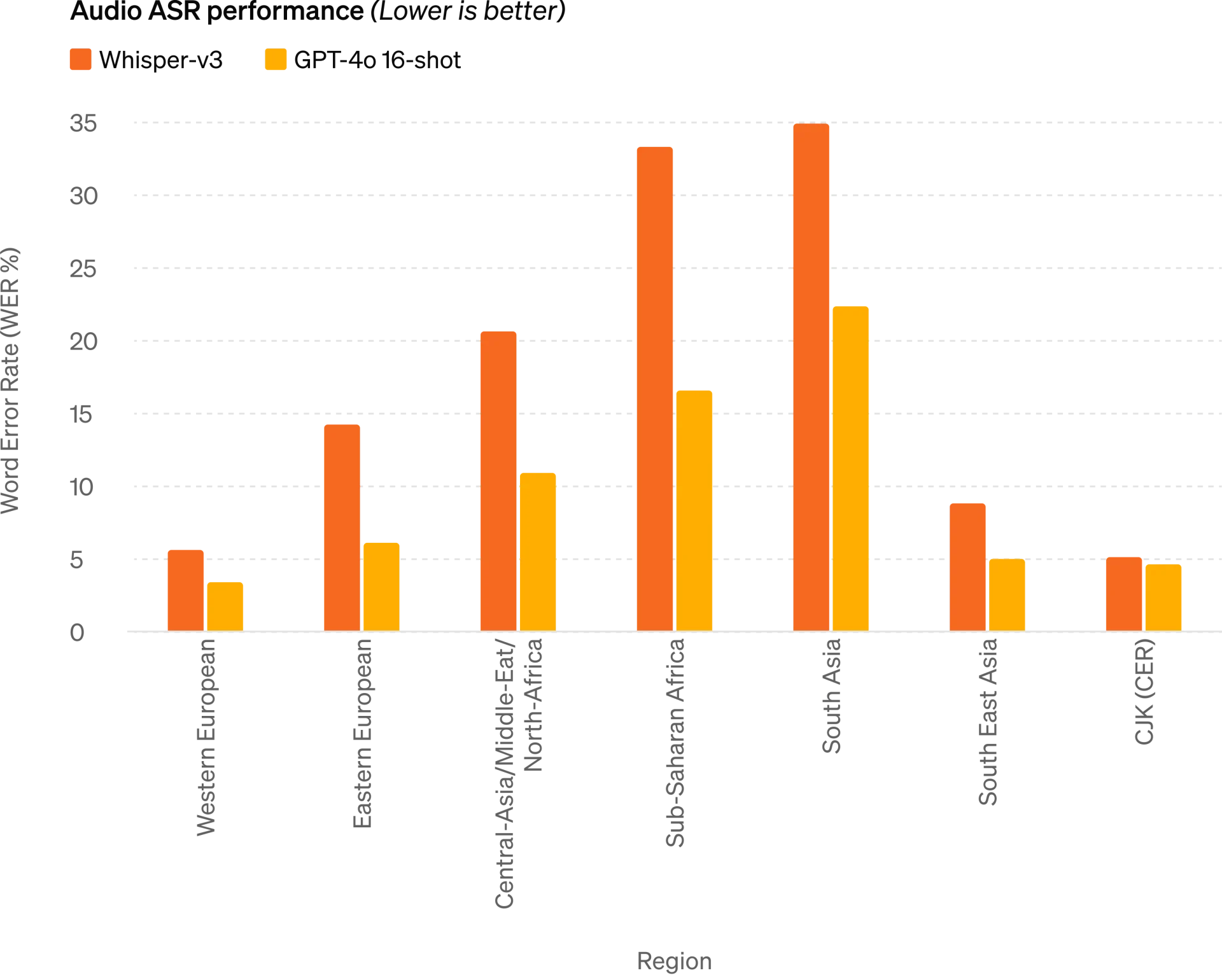

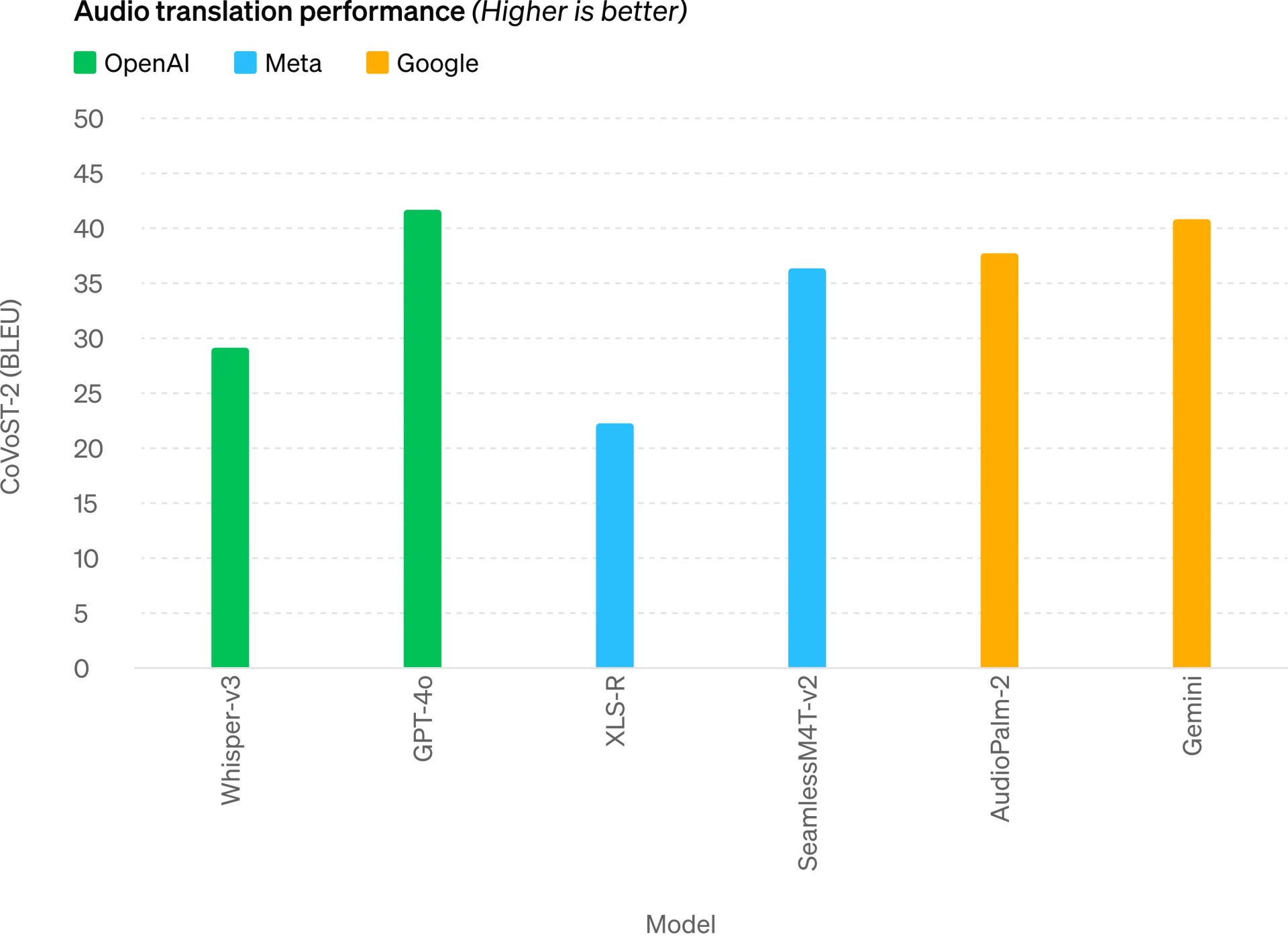

OpenAI 表示,GPT-4o 擁有極高的反應效能,能以平均 320 毫秒、最快 232 毫秒對語音輸入作出回應,幾乎等同人類對話的反應時間。除了在文字理解、程式編寫等傳統範疇保持 GPT-4 Turbo 的水準外,GPT-4o 在多語種支援(尤其是英文)、語音翻譯和視覺理解等能力上,也全面超越了 GPT-4、GPT-4T、Claude 3 Opus、Gemini Pro 1.5、Meta Llama3 400b 等競爭對手。

OpenAI 解釋了 GPT-4o 在語音模式上獲得大幅提升的原因。過去的語音模式是由三個模型接力運作:第一個將語音轉為文字、第二個 GPT 模型產生對話內容、第三個將文字轉回語音。然而,這種流程會導致主要的 GPT 模型無法直接觀察到語調、說話者、背景噪音等重要訊息,也無法輸出笑聲、歌唱或表達情緒。GPT-4o 則是訓練出一個同時處理文字、視覺和語音的單一模型,輸入輸出在同一神經網路內處理,因此互動的自然程度和表現力都大幅提升。

OpenAI 同時公開了大量展示 GPT-4o 能力的影片,包括作為翻譯人員、描述鏡頭中看到的 OpenAI 員工穿著、與員工進行人性化對話等,均展現出相當流暢和生動的表現,中間甚至能穿插停頓、笑聲等。有媒體更形容,影片中的 GPT-4o 聲音就像是 OpenAI 執行長 Sam Altman 最喜愛的電影《雲端情人》的女主角 Scarlett Johansson 一般。

根據 OpenAI 的說法,GPT-4o 的語音對話功能,未來將會先開放給 Plus 用戶使用,有付費購買 Plus 的使用者,可以稍微期待一下。

免費使用

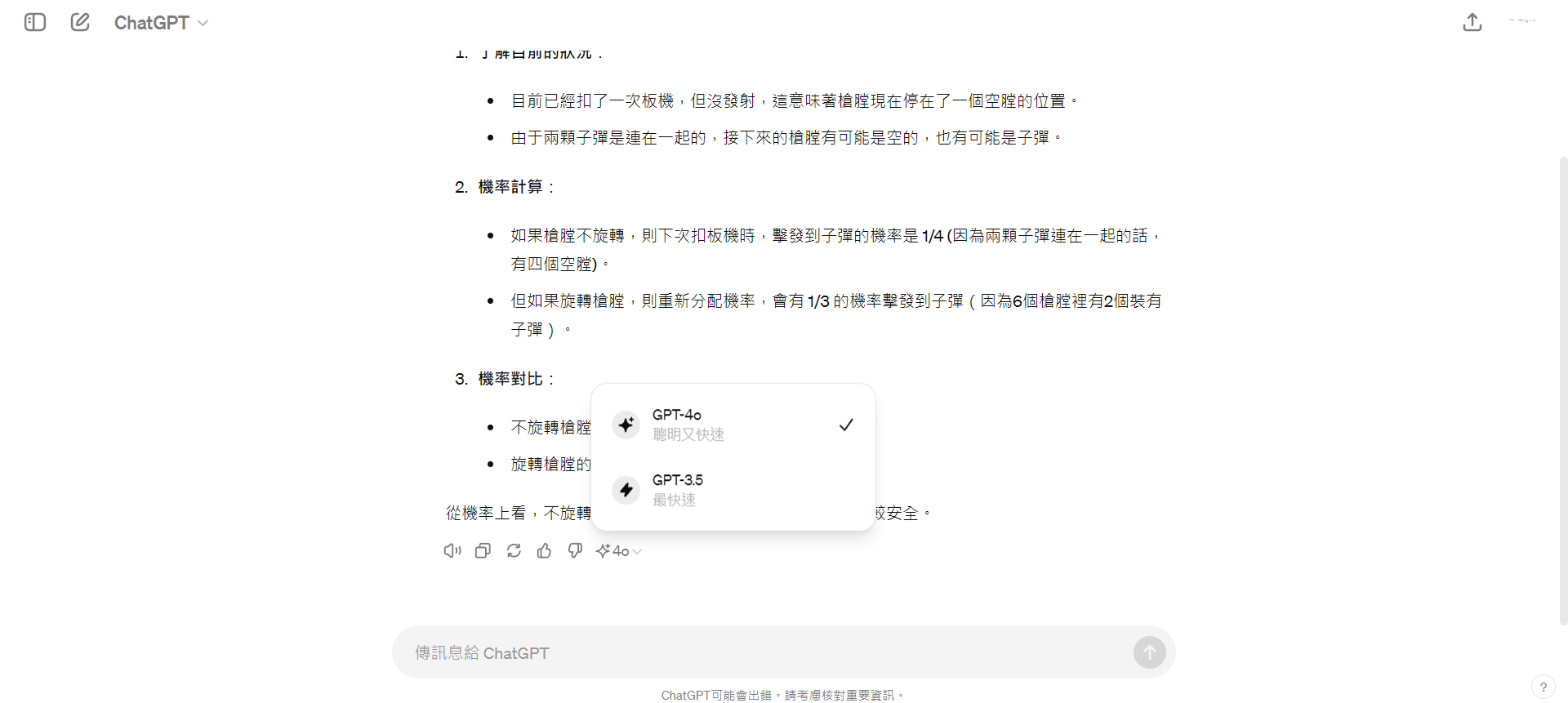

OpenAI 表示,GPT-4o 的文字和影像輸入輸出功能已開始在 ChatGPT 上線,免費用戶也可有限度使用。在目前寫稿的當下,應該已經有部份的 ChatGPT 帳號已經可以使用 GPT-4o 了。

我們只需要打開 ChatGPT 的網頁,若看到左上角的模型選擇是顯示 ChatGPT,而非 GPT-3.5 的話,就代表你已經可以使用 GPT-4o 了。

經過測試 GPT-4o 的對話生成速度,確實相當的快,幾乎跟 GPT-3.5 一樣,非常明顯的快於 GPT-4。

只是需要注意,目前免費用戶的 GPT-4o 的使用額度較少,稍微有點容易就會用到使用上限,此時 ChatGPT 的模型就會切換回 GPT-3.5。而付費版的訊息輸入上限則相較於免費版提高了 5 倍。

開發變的梗省錢: API價格減半、Tokenizer 更新

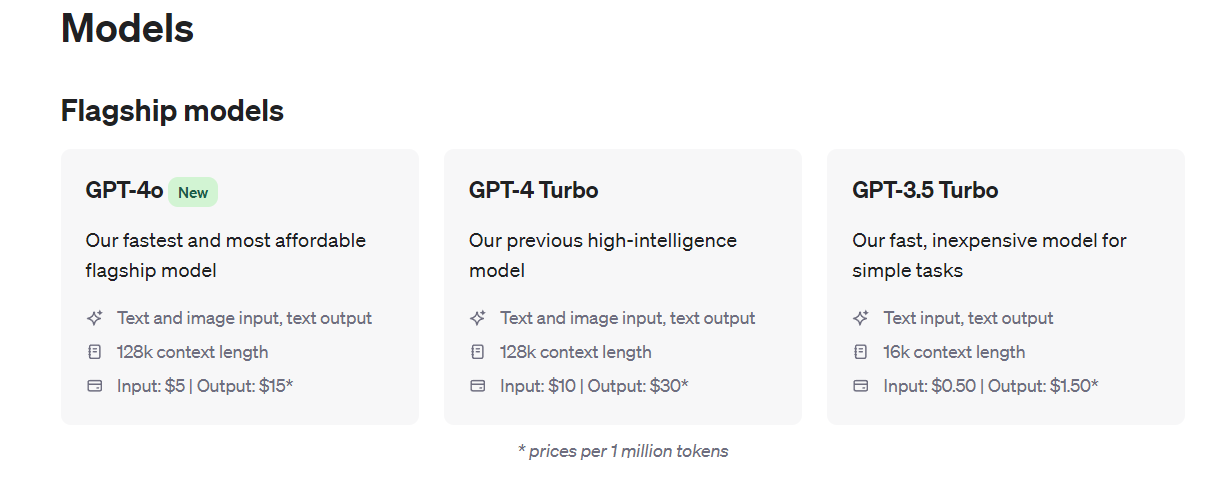

除了以上的更新之外,此次的更新還包含了一些對開發人員而言很有用的消息,就是 GPT-4o 的 API 價格僅為 GPT-4 Turbo 的一半,以及 Tokenizer 的更新。

API價格減半

GPT-4o 文字和視覺模型的 API 現已開放存取,相較之前的 GPT-4 Turbo,新模型的運算速度提升 2 倍、限制頻寬增加 5 倍,而價格卻僅為一半。OpenAI 計劃在未來幾週內,也將為少數合作夥伴開放 GPT-4o 語音和影片功能的 API 訪問。

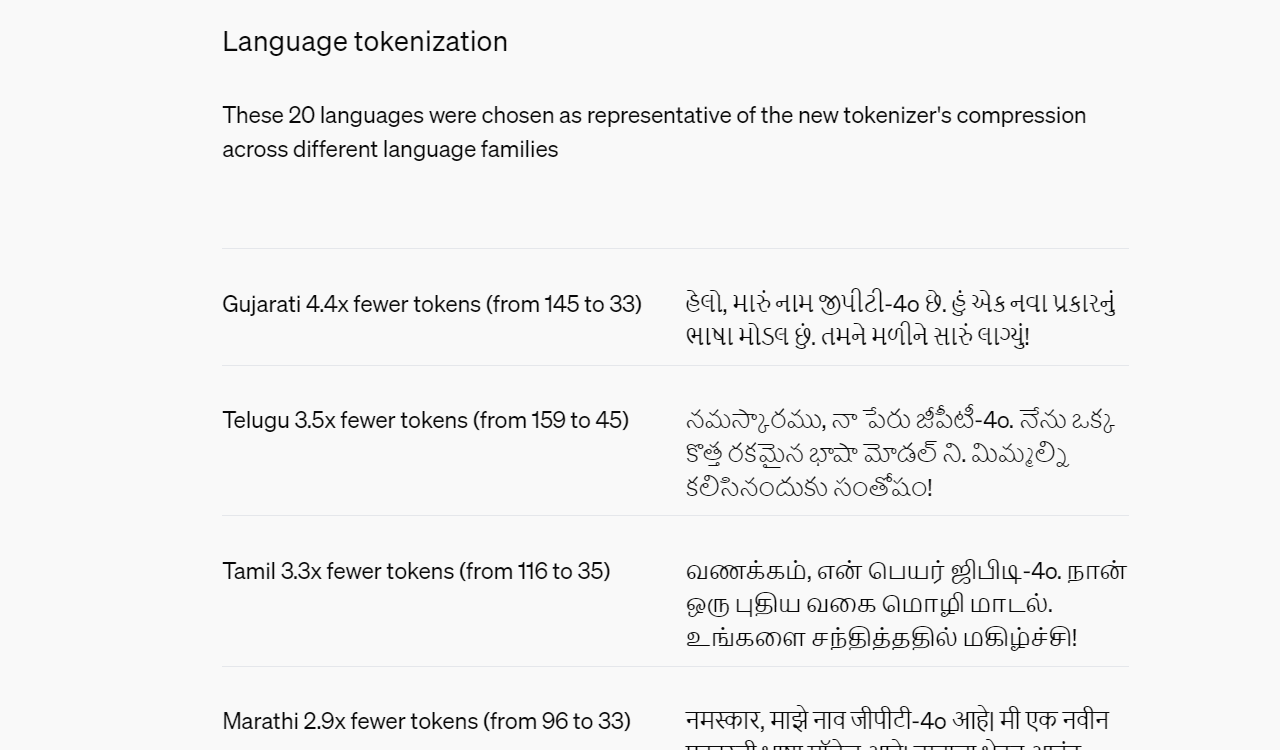

Tokenizer 更新

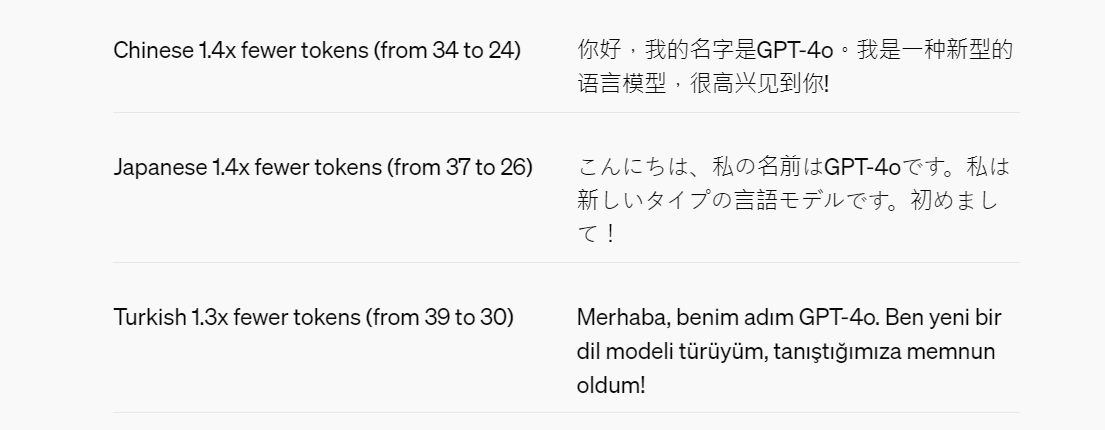

除了在多模態處理能力上的突破,GPT-4o 也在 Tokenizer 方面帶來重大改進。OpenAI 針對中文、英文、日文等 20 種語言,改善了 Token 計算方式,大幅減少了所需的 Token 數量。

以中文為例,相較之前,GPT-4o 在計算「你好,我的名字是 GPT-4o。我是一種新型的語言模型,很高興見到你!」這句話時,所需的 Token 數量從 34 個減少到僅 24 個,節省了 1.4 倍。

由於包括 OpenAI 在內的語言模型 API 都是以 Token 數量計價的,這項 Tokenizer 改良搭配上 GPT-4o 的每百萬 tokens 價格減半,可以大幅的減輕開發人員的使用成本負擔,也有助於提升 GPT-4o 的運算效率。

安全疑慮

儘管 GPT-4o 展現出驚人的能力,但 OpenAI 也意識到它可能帶來的安全風險。因此,GPT-4o 在設計上就內建了跨模態的安全防護措施,例如過濾訓練數據、透過微調來改善模型行為等,同時也制定了新的安全系統,為語音輸出設置防範機制。

OpenAI 根據其整備度評估框架和自願承諾,對 GPT-4o 在網路安全、CBRN 威脅、誘騙能力及模型自主程度等層面進行了評估。評估結果顯示,GPT-4o 在上述任一領域的風險等級均未超過中度。這項評估是在整個模型訓練過程中,透過自動化和人工評估的綜合測試而得出的結果,包括在安全緩解措施實施前後,使用定制的微調和提示來更好地引出模型能力。

此外,GPT-4o 還經過了 70 多位社會心理學、偏見公正性和防止假訊息等領域的外部專家進行了廣泛的紅隊評估,以識別新增模態可能帶來或加劇的風險。OpenAI 將這些經驗教訓融入安全干預措施,以提高與 GPT-4o 互動的安全性,並將持續努力來緩解日後發現的新風險。

OpenAI 認識到,GPT-4o 的語音模態存在各種新穎的風險。因此,目前公開發布的僅包括文字和影像輸入以及文字輸出。在未來的幾週和幾個月內,OpenAI 將專注於建立必要的技術基礎設施、透過微調提升可用性,以及制定安全措施,以發布其他模態的功能。例如,在發布之初,語音輸出將僅限於一些預設的聲音,並將遵守現有的安全政策。OpenAI 將在即將發布的系統卡片中,詳細介紹如何全面處理 GPT-4o 各種模態的相關問題。

在測試和反覆優化 GPT-4o 的過程中,OpenAI 也觀察到該模型在所有模態上都存在一些局限性,部分局限性如下所示。

結語

最後,GPT-4o 標誌著 OpenAI 在多模態 AI 領域達到新的里程碑。無論是其卓越的能力表現、開放免費用戶使用的決定,還是對開發人員更加實惠的定價策略,GPT-4o 都值得我們高度關注和期待其未來的發展成果。