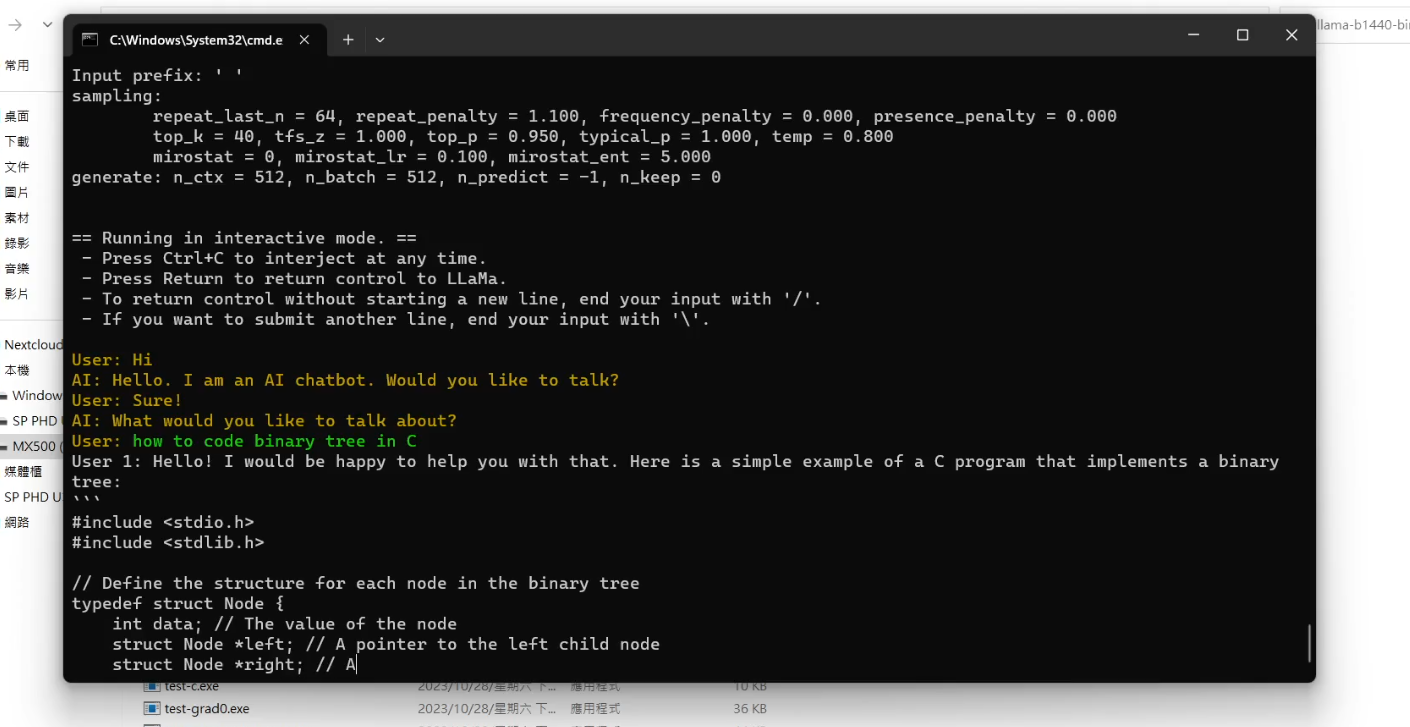

現在在網路上我們已經可以找到許多開源的語言模型。想要玩一下的話,模型也都可以在 HuggingFace 上找到。這些語言模型雖然大多都可以直接使用 llama.cpp 來跑,但在 CMD 或 Terminal 裡執行,體驗方面肯定不算是很好。

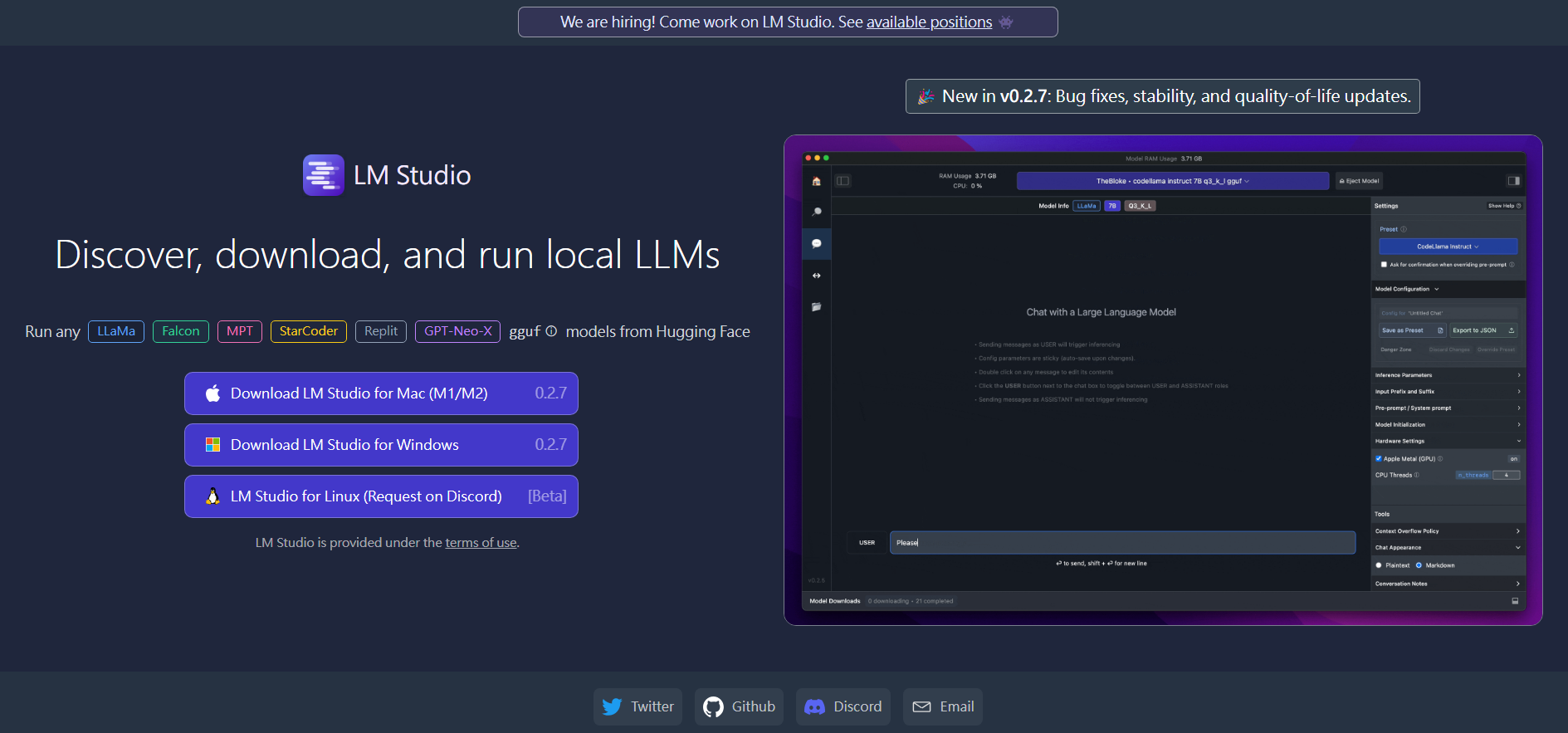

所以今天我們要來跟大家介紹一個名為【LM Studio】的程式,這個程式是一個語言模型的使用與管理介面,它提供了方便使用的聊天介面,以及模型管理介面。讓我們在使用各種語言模型時,可以更加的方便。

LM Studio介紹

首先要使用這個程式,我們可以直接到它的官網 lmstudio.ai 下載。

目前(2023.10.29)雖然 Linux 平台的版本還在 Beta 階段,但基本上也可以算是支援主流的 Windows、Linux、MacOS 三大平台了。

LM Studio 使用 llama.cpp 來跑語言模型,可以做到在下載好模型後,完全離線執行。

並且重點是,LM Studio 提供了一個很好的的模型管理、下載、聊天介面。讓們在使用語言模型時,可以更加的便利。

在他的網站介紹中也有提到,他可以開一個與 OpenAI 兼容的本機伺服器,讓我們可以更輕鬆的將一些需要呼叫 OpenAI API 的程式,改成完全在本機上跑。像是在本機跑 Code Llama,搭配 VS Code 的擴充功能使用。

LM Studio使用教學

首頁

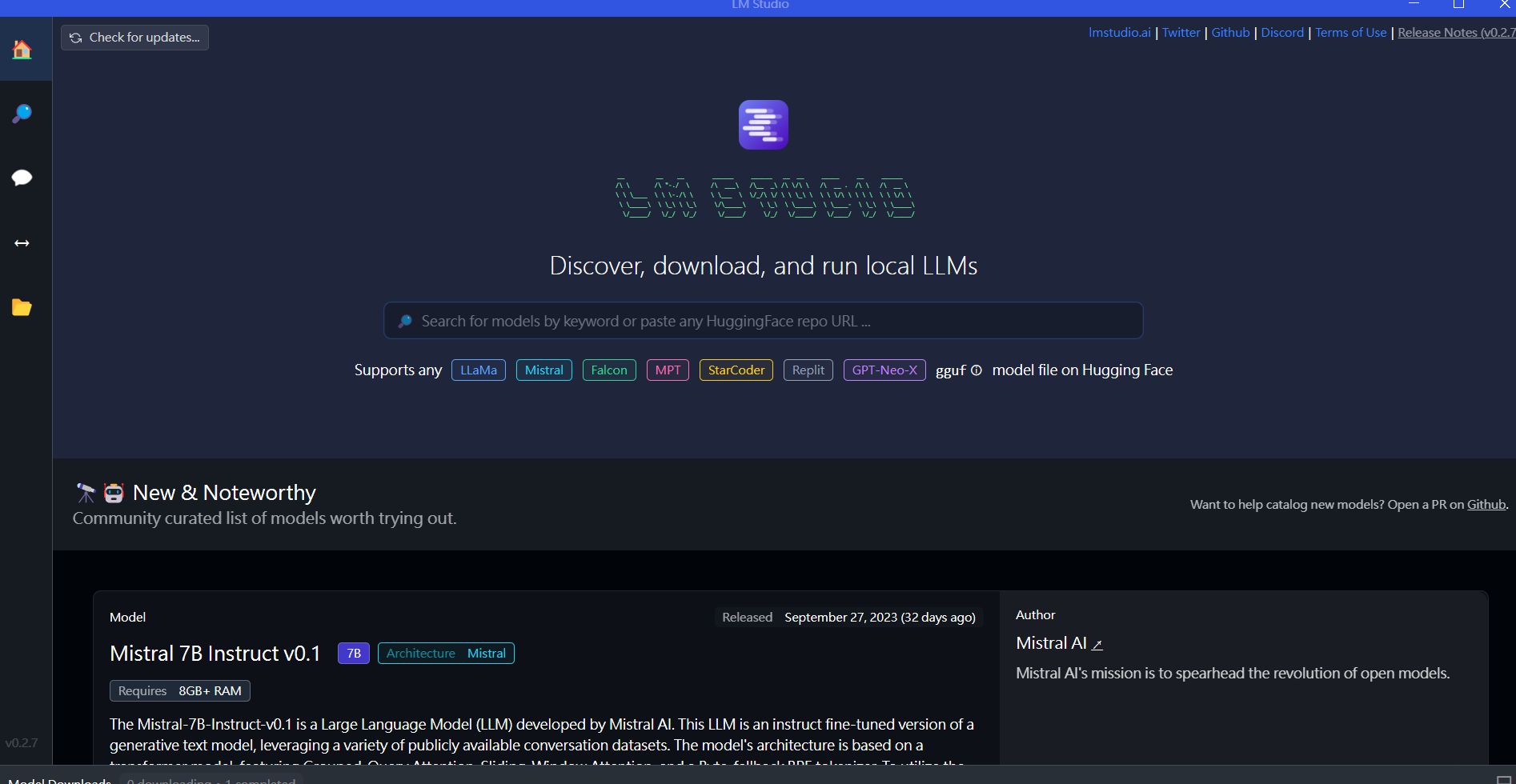

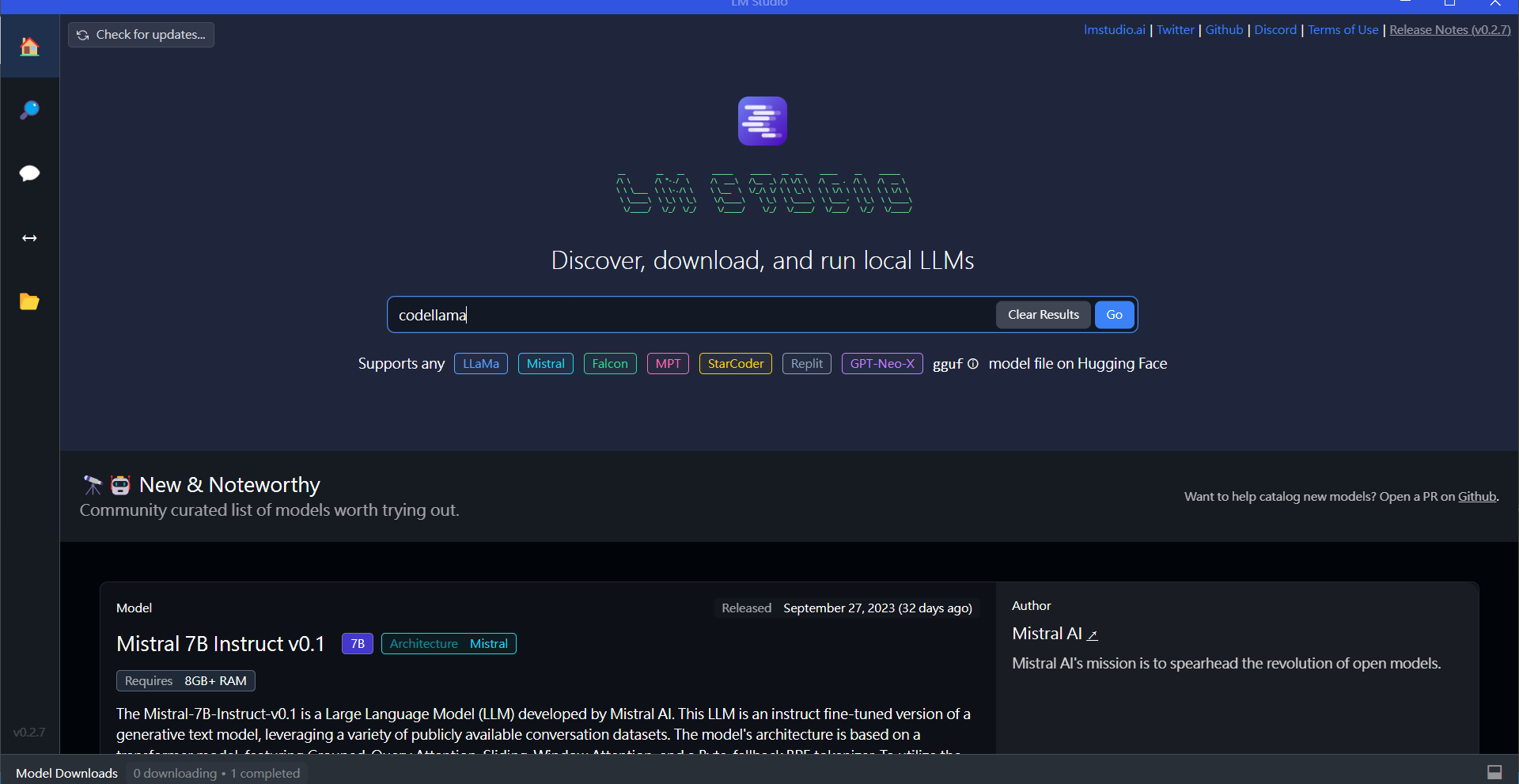

安裝完 LM Studio 後,打開程式就會看到 LM Studio 的首頁。

在這裡我們可以看到 LM Studio 支援的各種語言模型,並且有搜尋欄可以直接搜尋我們想要的模型。

往下滾動,則是可以看到一些跟語言模型相關的新聞。

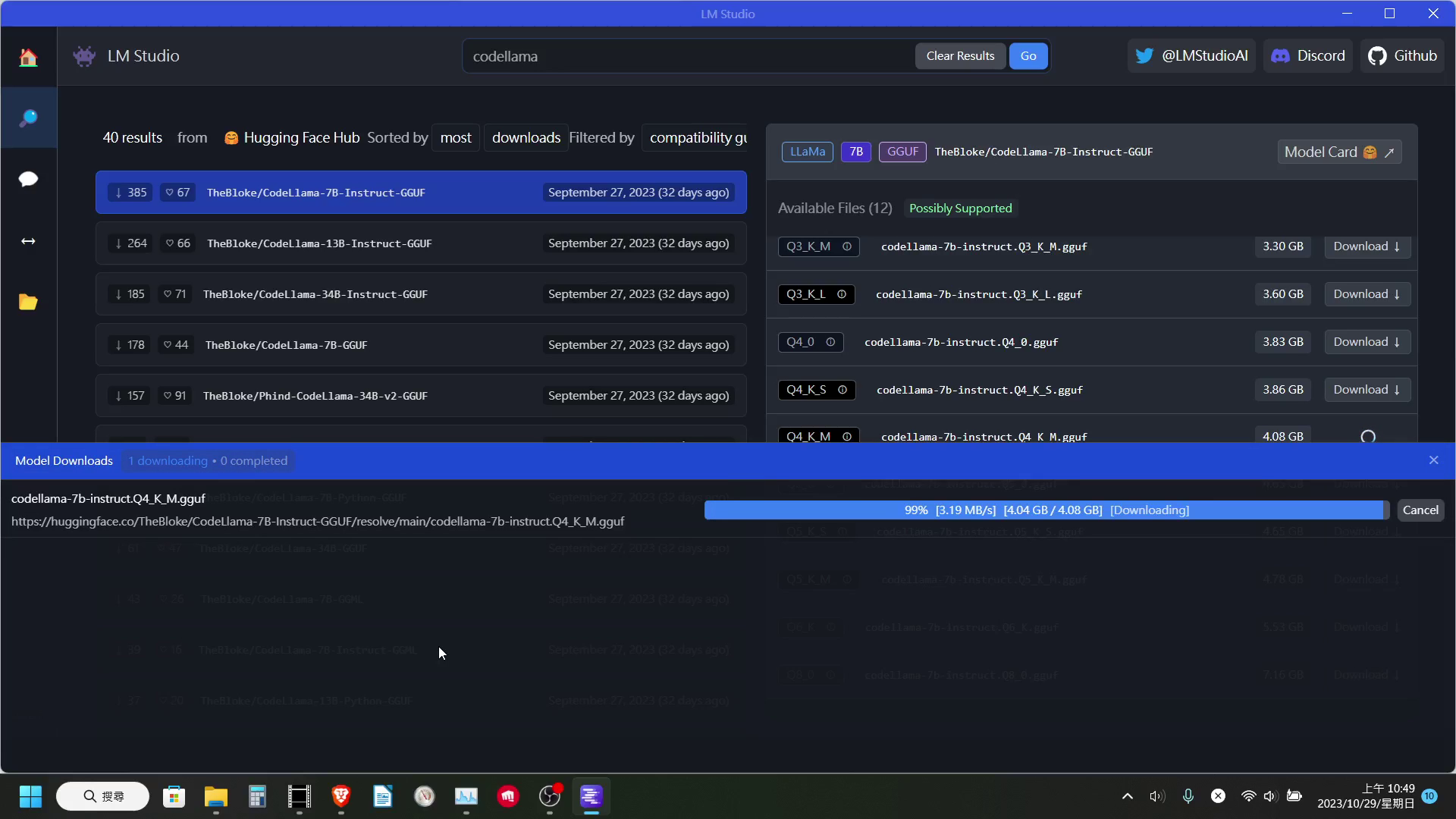

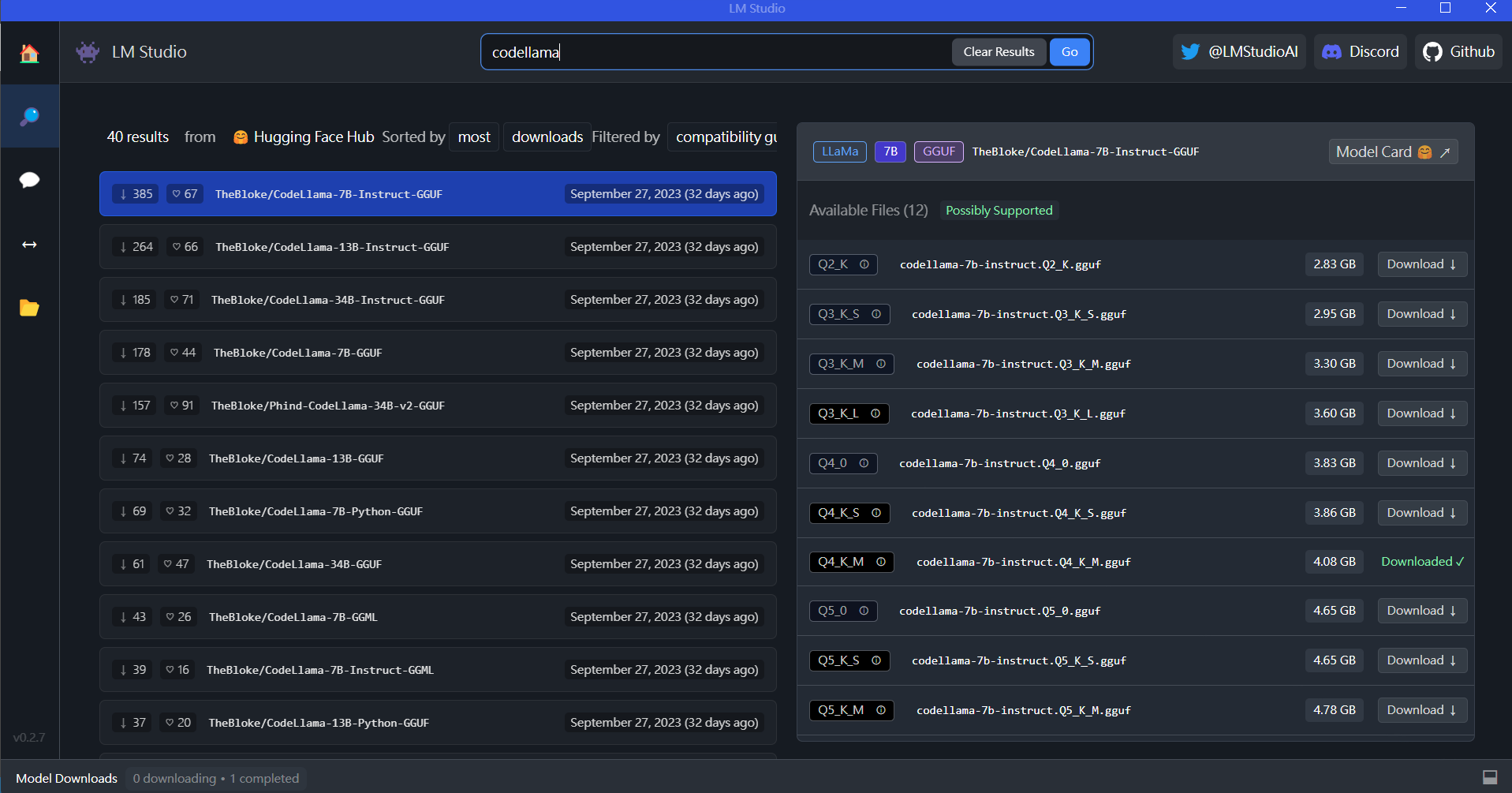

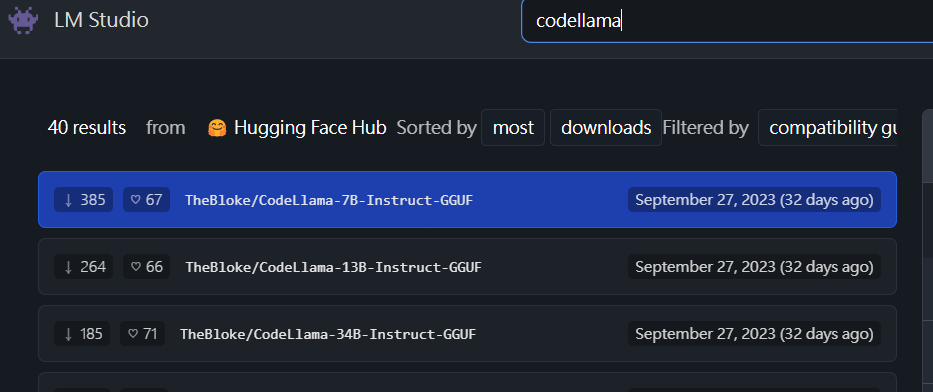

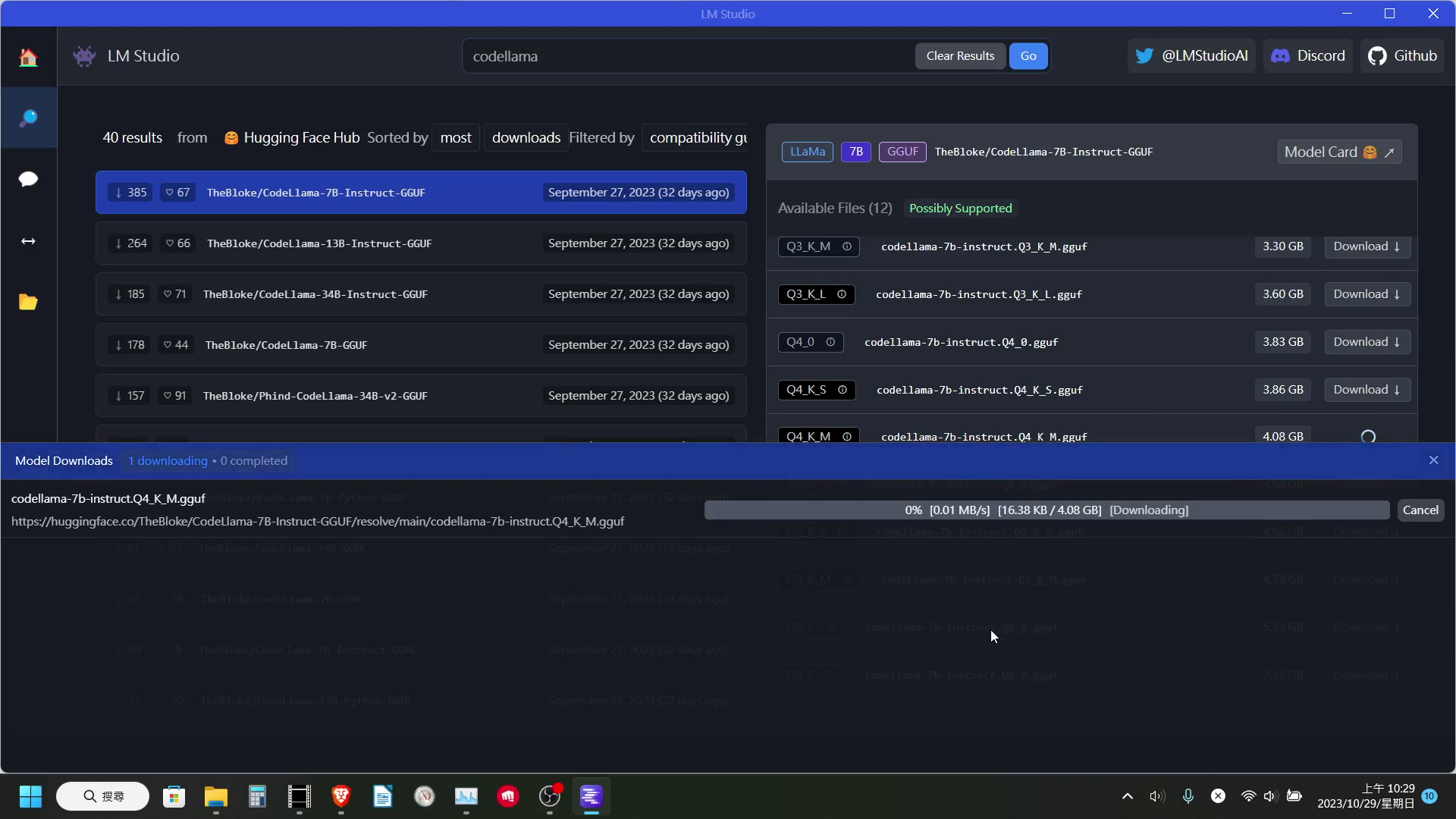

這邊搜尋的部分我輸入【codellama】來做示範。再輸入完後按 Enter,就會跳轉到搜尋的頁面。

搜尋頁面

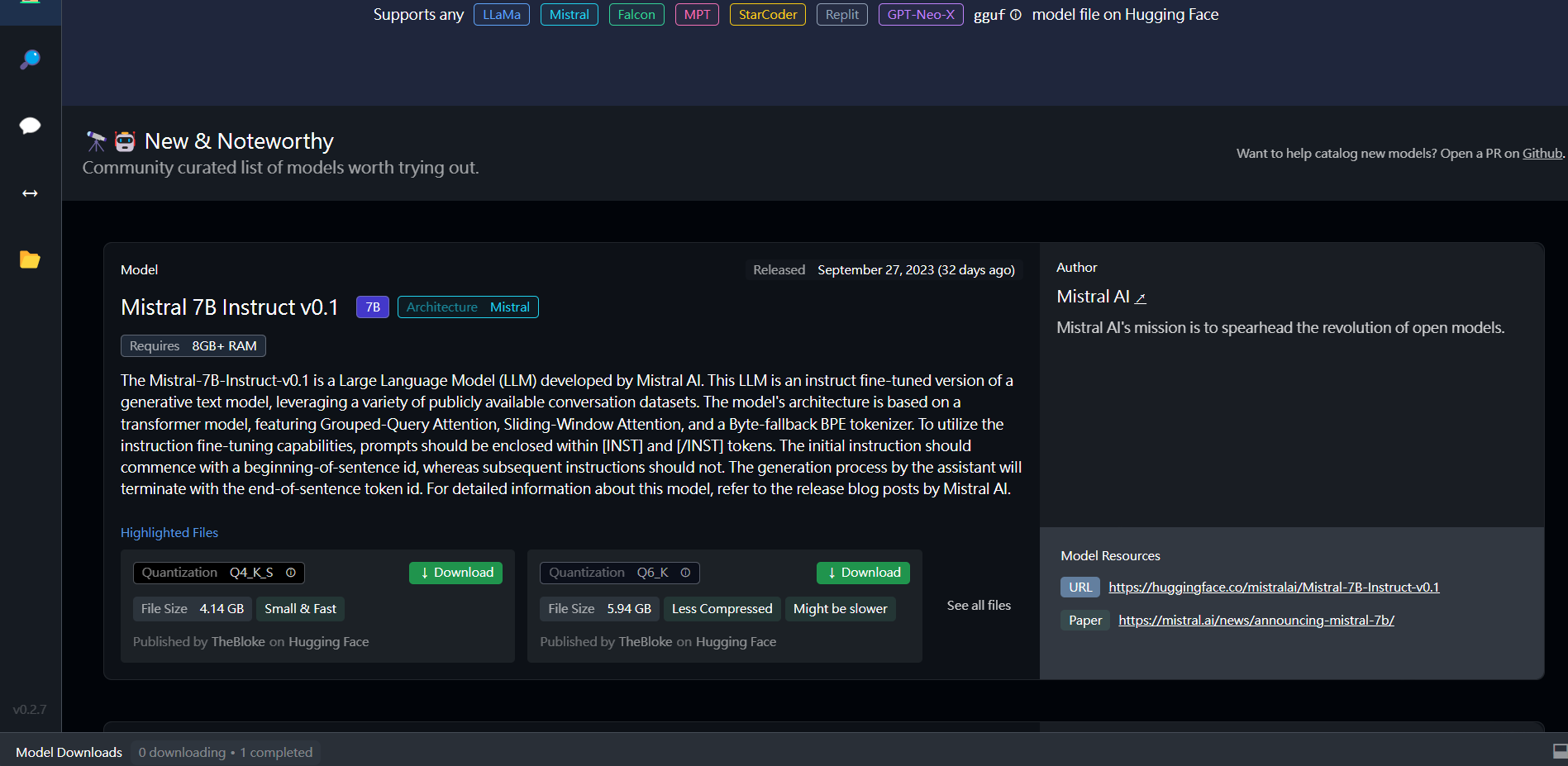

搜尋頁面裡的搜尋結果使從 HuggingFace 上抓取的,所以如果再 HF 上找的到的模型,理論上這裡也能找的到。

在這個搜尋頁面的左側大家應該是不太會有疑問,因為就只是列出各個搜尋到的結果。

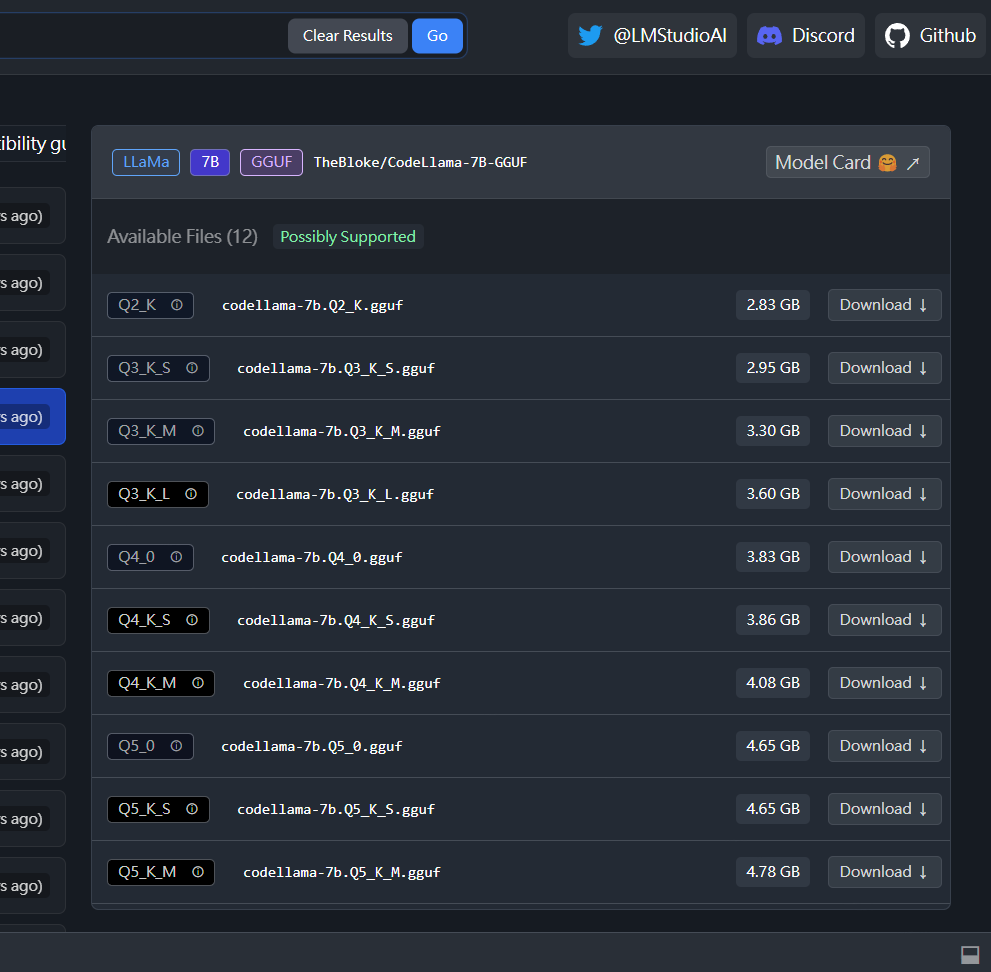

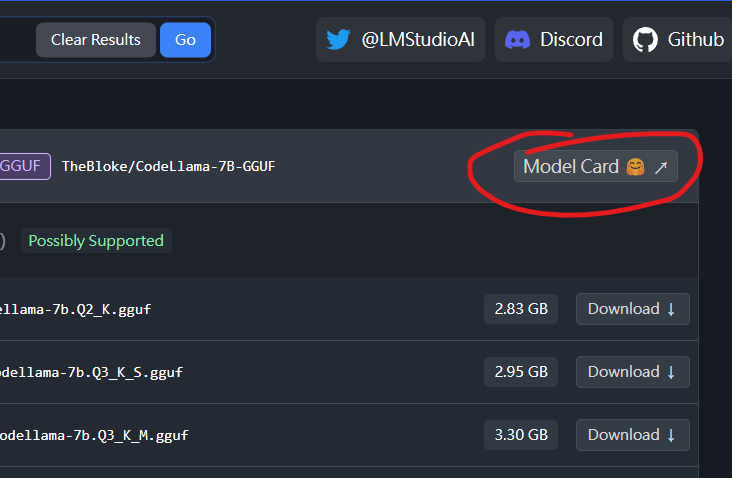

但是右側的部分,大家看到一堆的下載按鈕,可能就會感到困惑了。

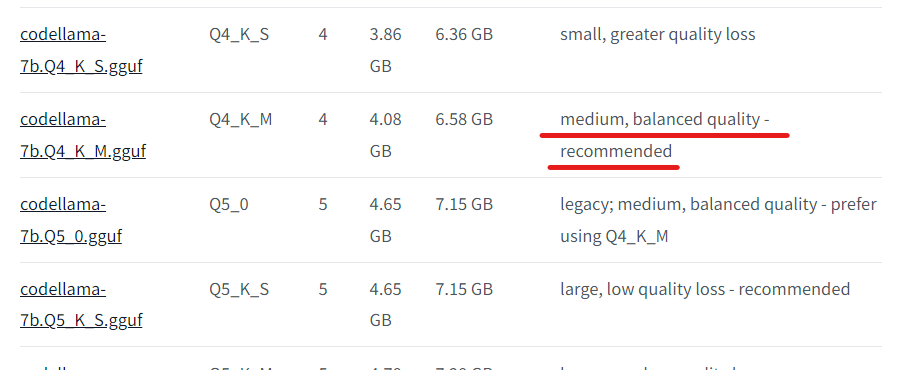

模型選擇

這邊我個人建議可以下載 Q4_K_M 的版本,我們可以點右上角的 Model Card 按鈕,進到 HuggingFace 裡查看,就能看到 Q4_K_M 是大小與品質比較平衡的版本,同時也是建議的版本之一。

在選好要使用的模型後點下載,等到他下載完,我們就可以進到聊天頁面,開始使用語言模型了。

聊天介面

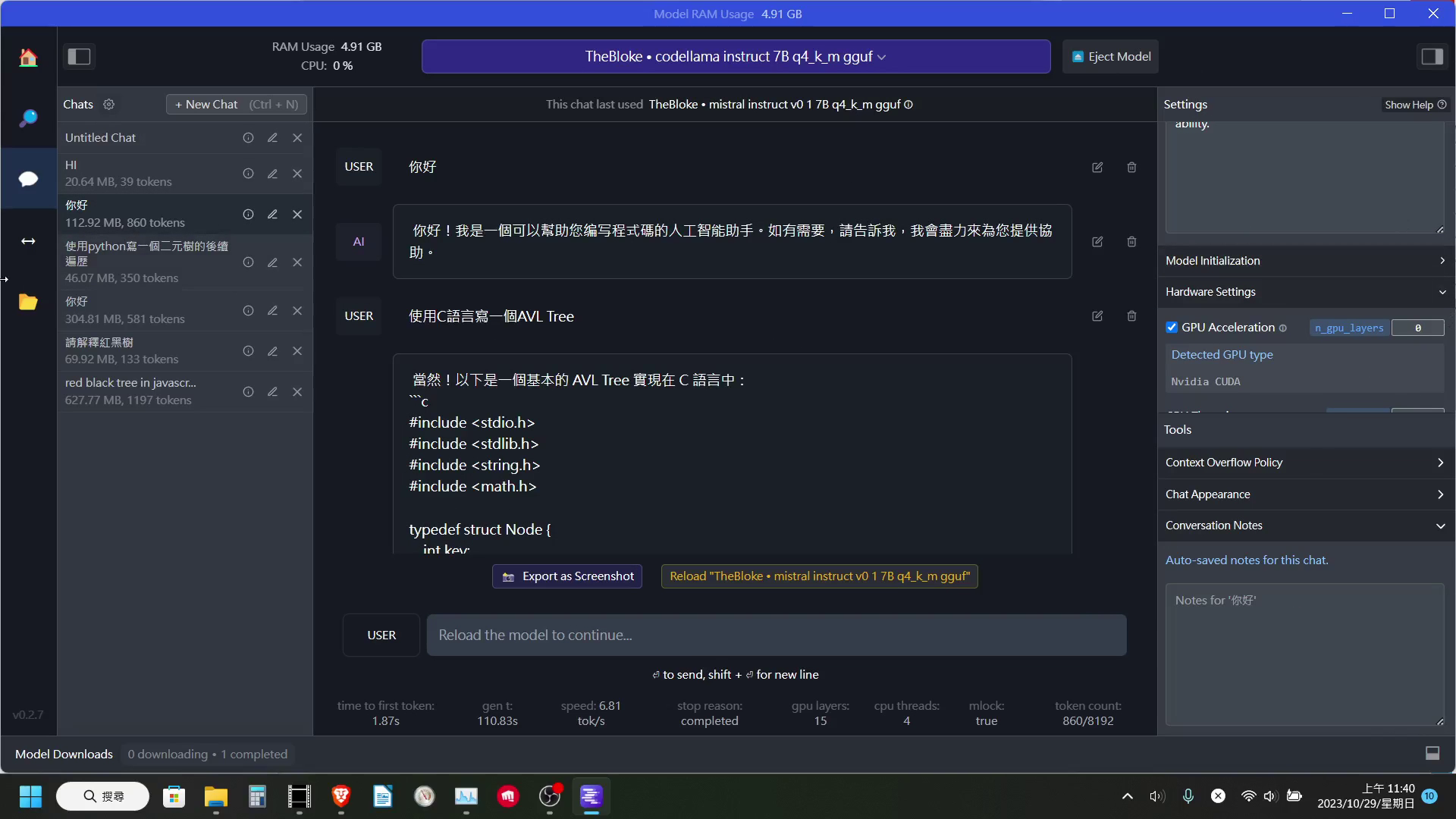

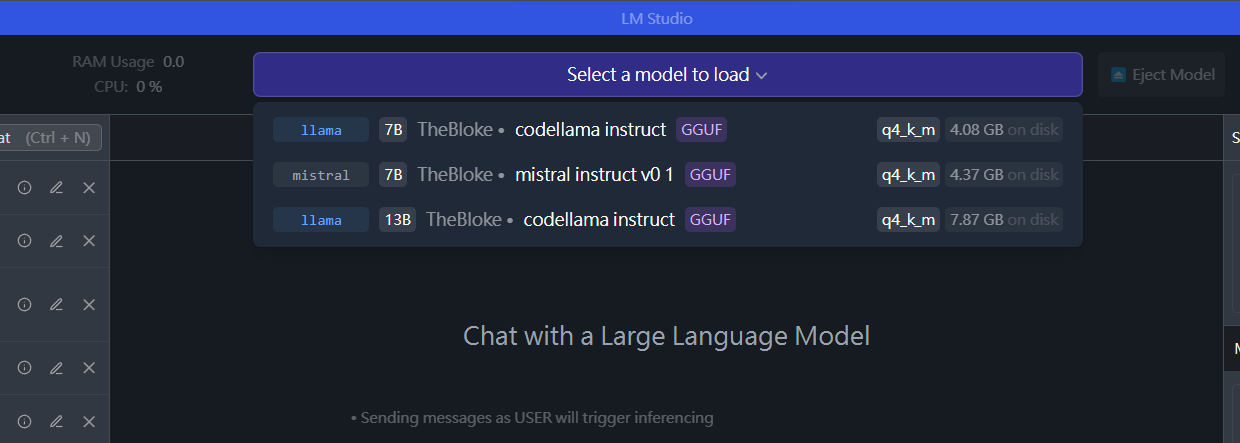

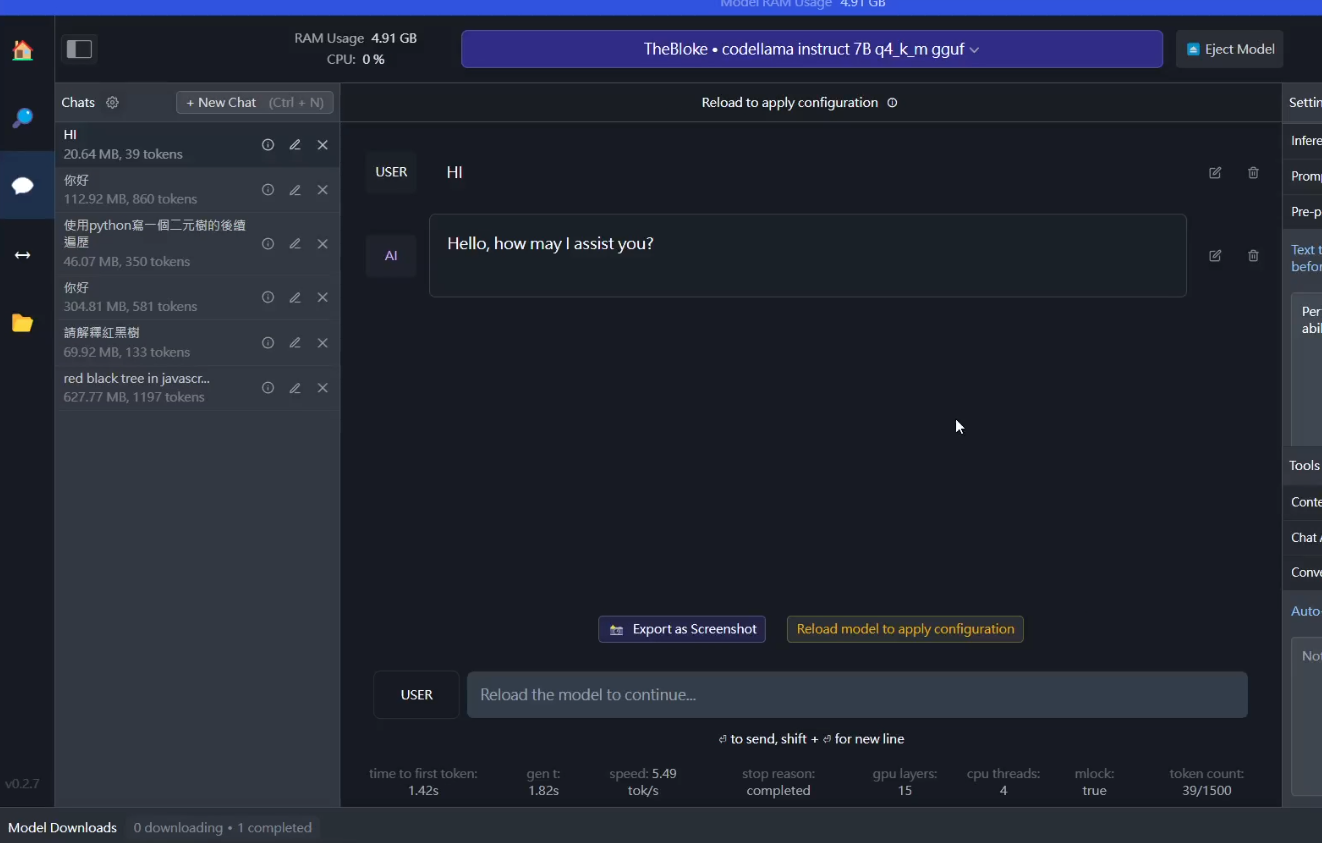

在進到聊天介面後,我們需要先到上方載入我們想要使用的模型。同時在上方也會顯示目前使用的 RAM 以及 CPU。

聊天介面的左側與中間,基本上就是聊天視窗切換,以及聊天介面。

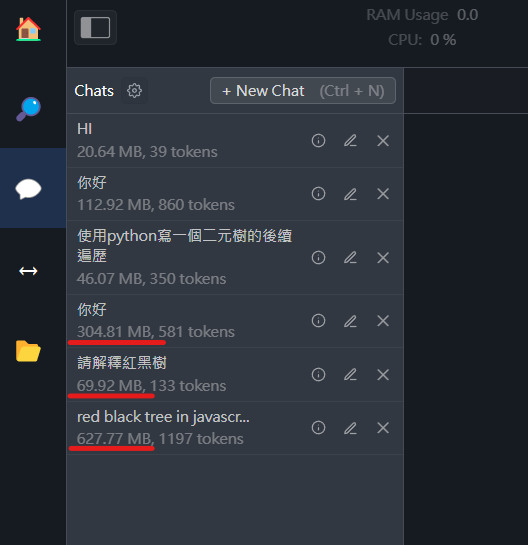

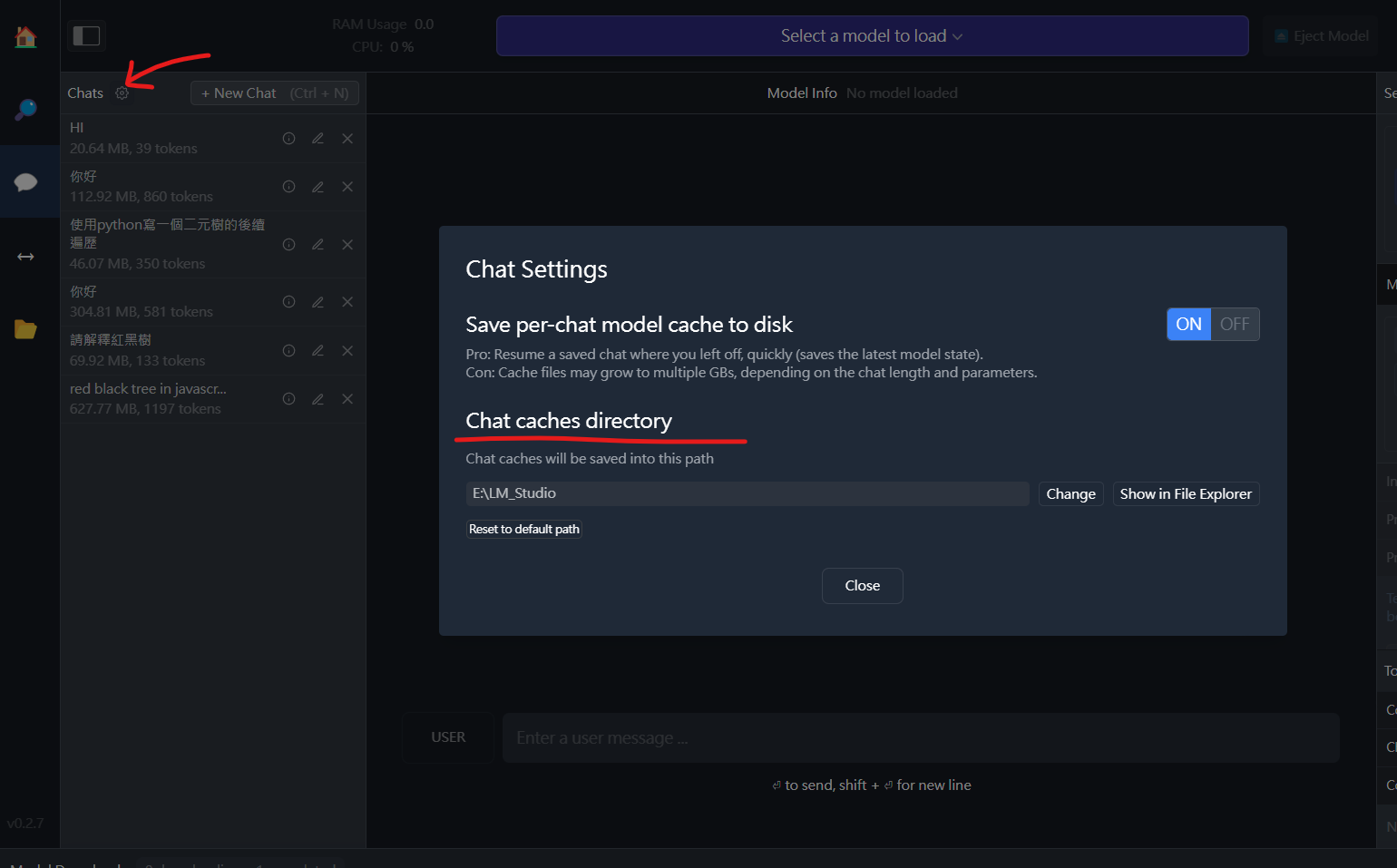

這邊有一點可以注意一下,每個聊天視窗的檔案其實不算小,有需要的話可以點開設定調整一下聊天室的儲存位置。

設定

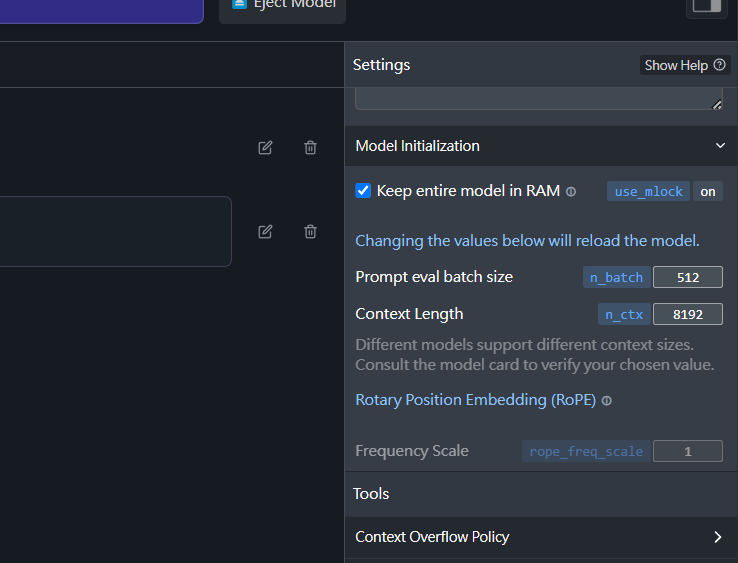

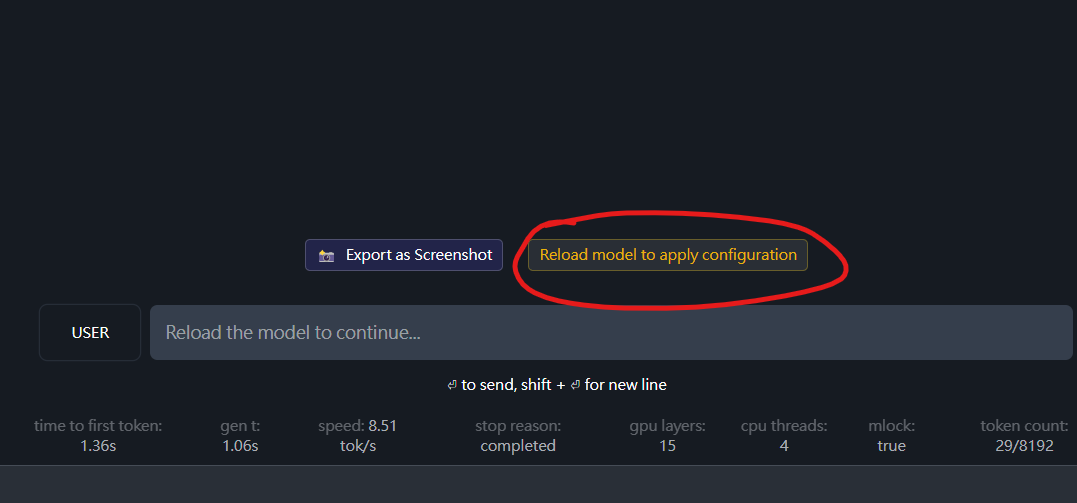

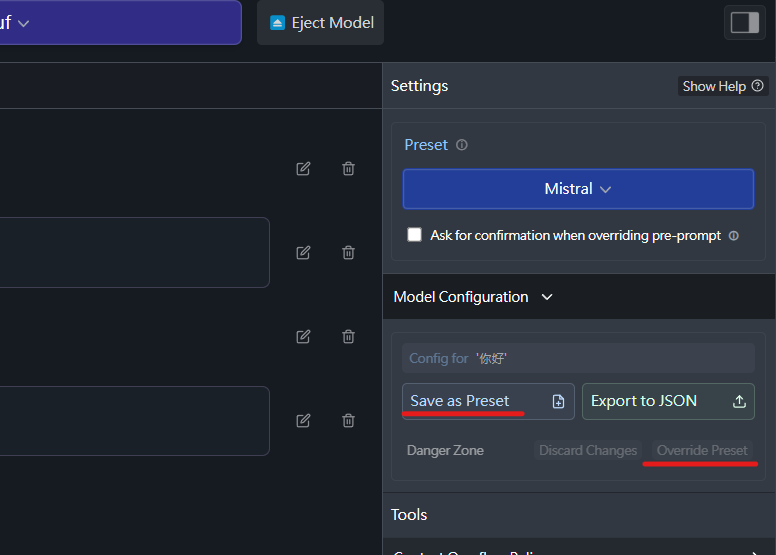

在聊天介面的最右側,還有一個設定的欄位。這裡的設定在不同的聊天視窗間,是獨立的,我們可以為每個聊天室窗,都弄一個設定數值。

只是要注意,如果設定值不同,在切換聊天視窗時,需要重新載入一次模型,才會套用該聊天室的設定值。

Preset 設定檔

如果調整出了一個很合適的參數設定,我們可以將該組設定儲存成一個新的 Preset,讓未來再開啟新的聊天室時,可以直接套用。當然想要的話,也可以將其覆蓋至目前所選擇的 Preset。

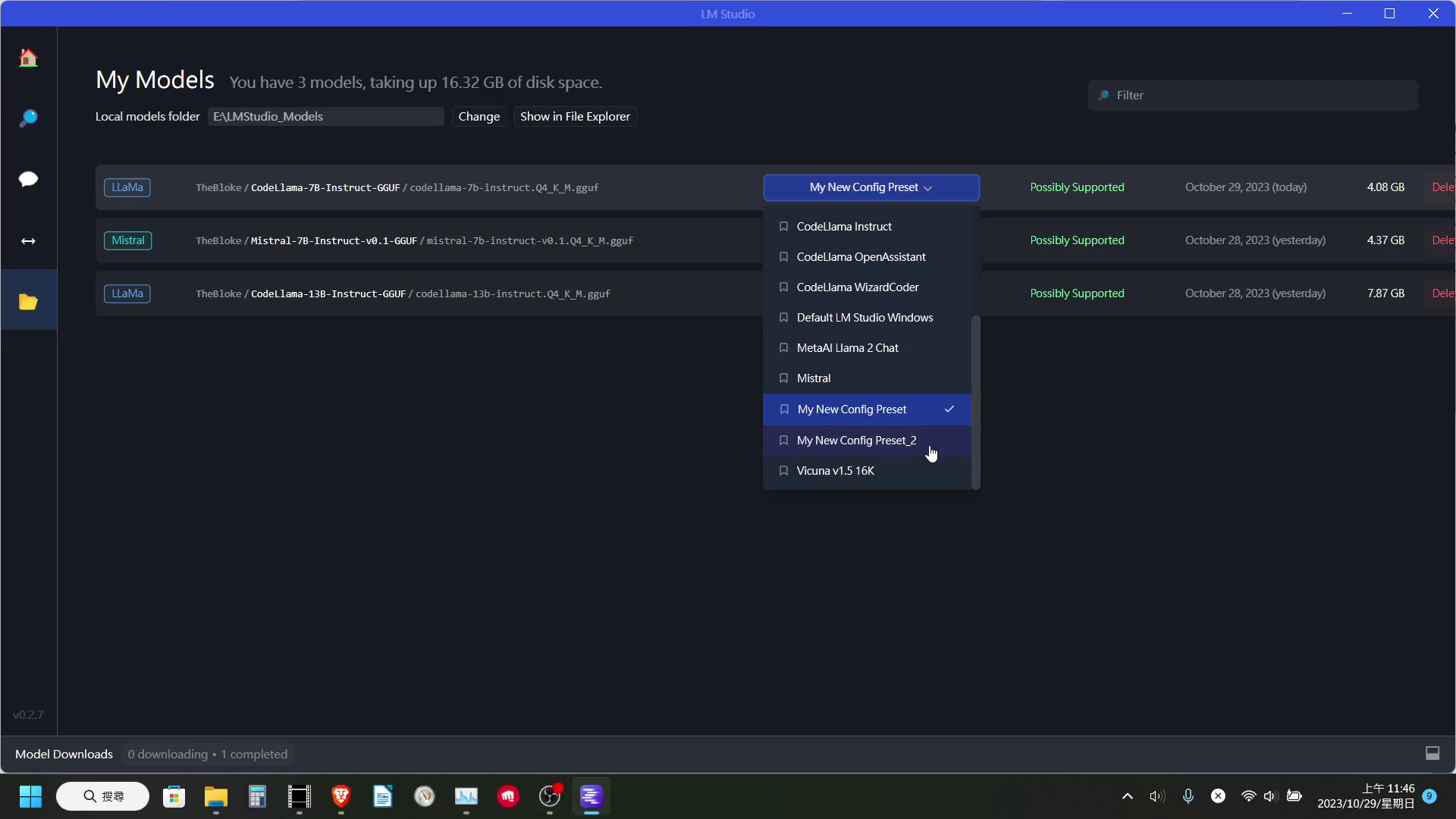

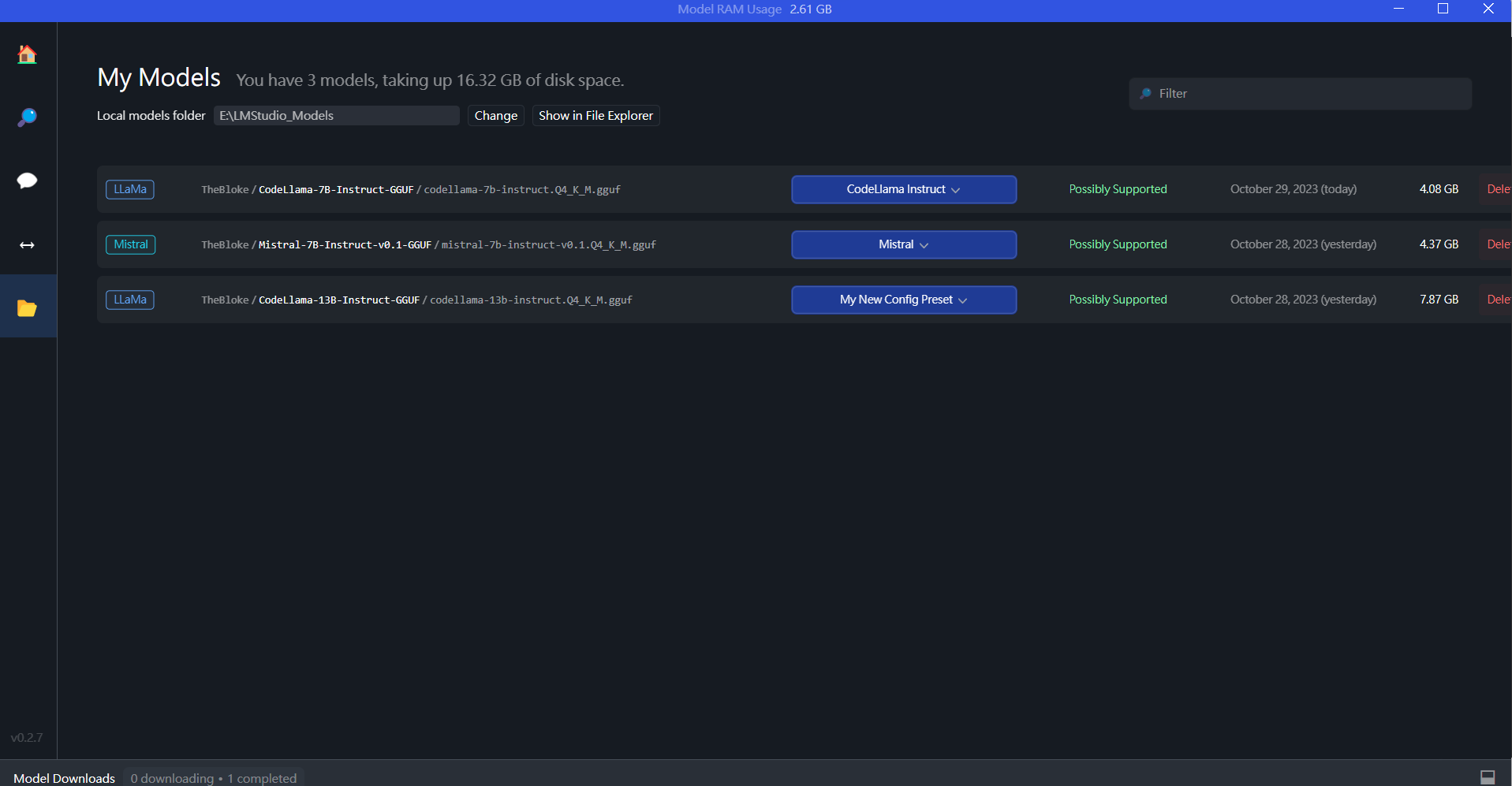

模型管理頁面

點擊左側選單最下方的資料夾圖標,我們就可以進到模型的管理頁面。

在這裡我們可以查看、刪除我們下載的模型,以及為各個模型選擇開新聊天室時使用的 Preset。

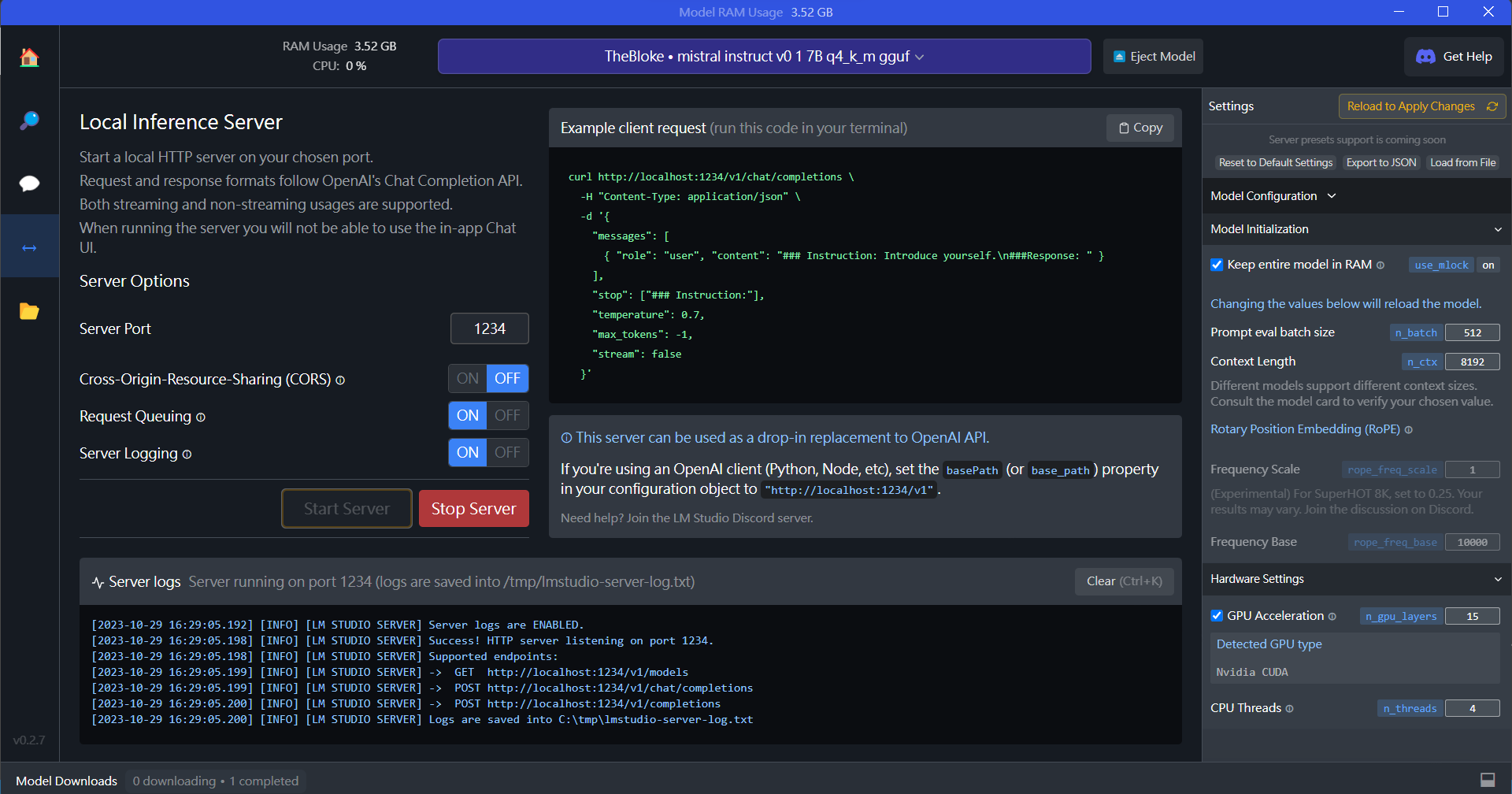

本機伺服器頁面

最後我們來介紹 Local Server 頁面。

在這個頁面裡,我們可以開啟一個與 OpenAI API 相容的本機伺服器。使我們可以將一些呼叫 OpenAI API 來使用語言模型的程式,改成使用我們自己的電腦來執行。

以下我拿【如何在 VS Code 中使用 Code Llama】來做示範

在 VS Code 中使用 Code Llama

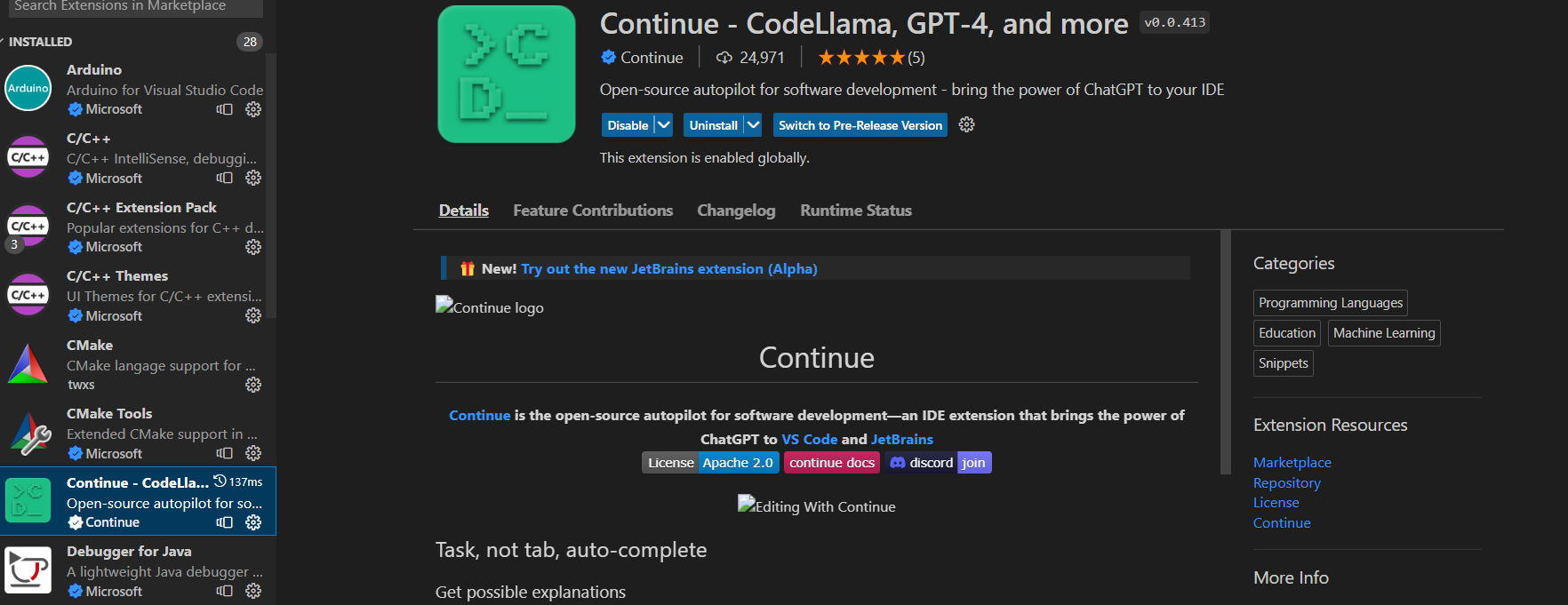

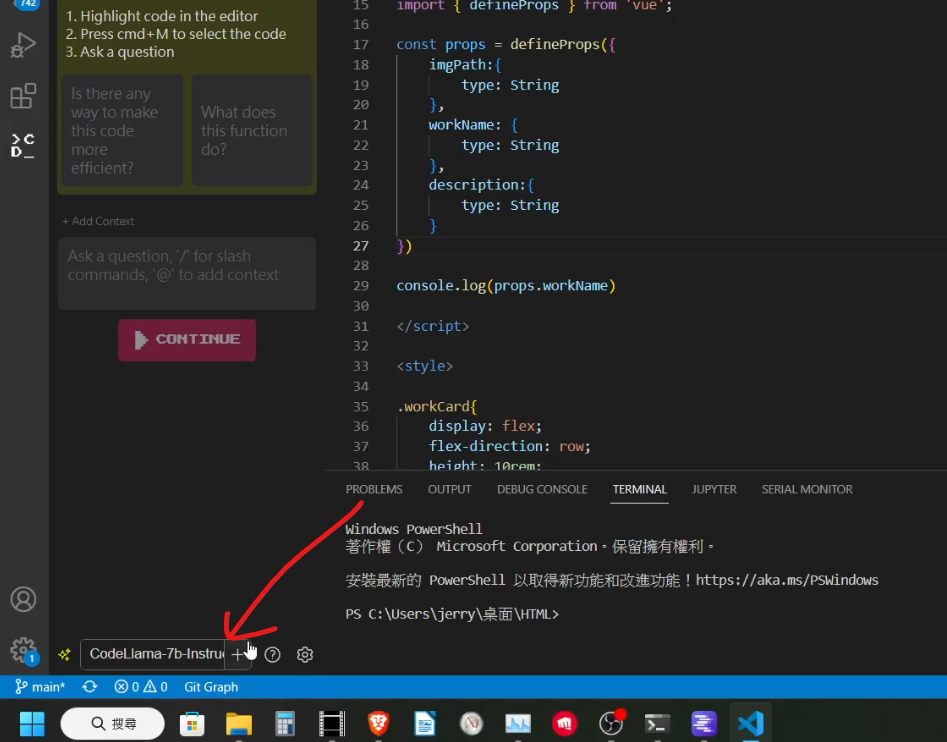

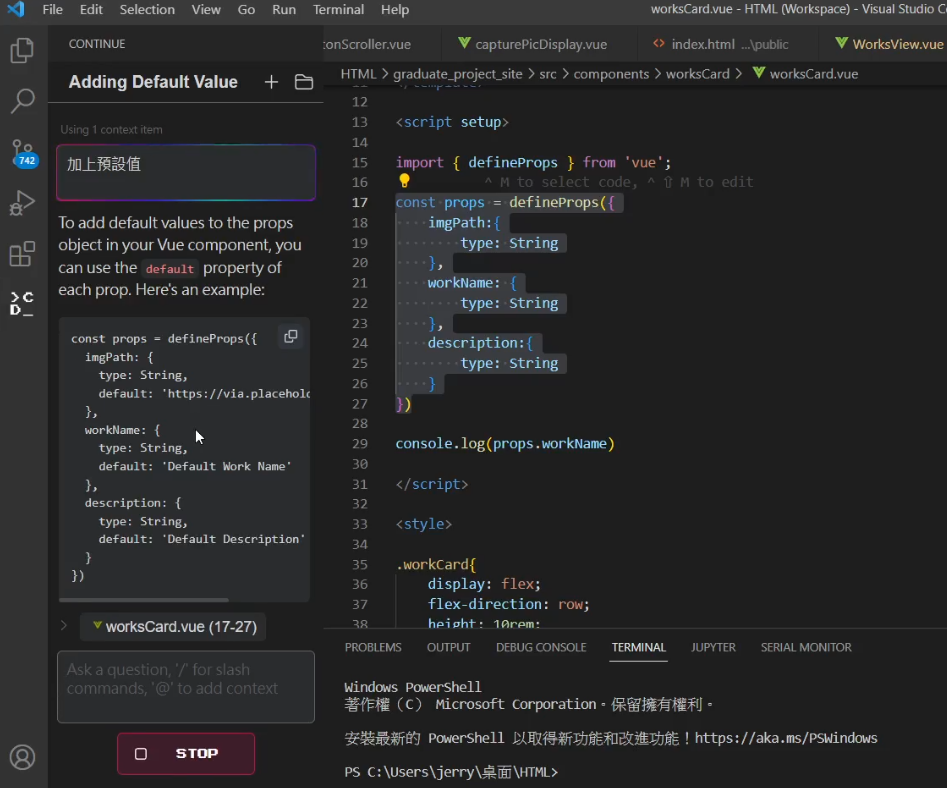

在開啟 Local Server 後,我們可以透過 Continue 這個擴充功能,來呼叫 LM Studio 開啟的這個伺服器。

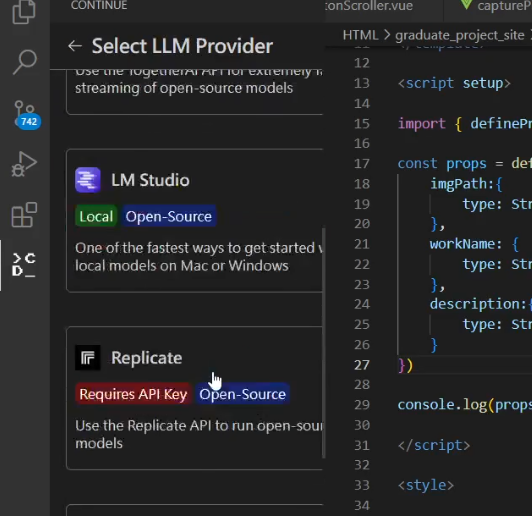

在安裝完 Continue 後,我們點開 Continue 的標籤,並點擊下方模型選擇旁邊的【+】號。

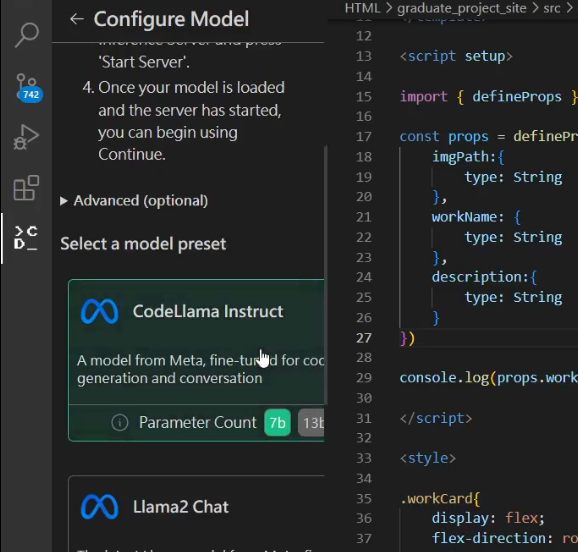

便可以在裡面找到 LM Studio,並在內層找到 Code Llama、Mistral 等模型。

接著就可以在 VS Code 中使用 Code Llama 了

結語

LM Studio 個人感覺算是一個相當方便的程式介面

它將使用大型語言模型的門檻拉低了很多

讓大多數使用者只要有電腦就可以非常方便的使用

不太需要去擔心參數、模型管理等地問題

非常值得嘗試

(P.S.若有錯字或是內容有誤,歡迎在下方留言指教)