OpenAI 於 2025 年 4 月 14 日投下震撼彈,正式發布了新一代旗艦級大型語言模型系列:GPT-4.1、GPT-4.1 mini 與 GPT-4.1 nano。此次更新不僅標榜性能全面超越現有的 GPT-4o 系列,更將上下文處理能力推升至驚人的 100 萬 Token,知識庫也更新至 2024 年 6 月。

與以往不同的是,GPT-4.1 系列目前僅透過 API 提供給開發者使用,旨在賦能開發者建構更複雜、更專業的 AI 應用。而廣受用戶喜愛的 ChatGPT 將繼續由持續優化的 GPT-4o 模型提供服務。同時,原先備受期待的 GPT-4.5 被定義為研究預覽版,並宣布將於 2025 年 7 月 14 日功成身退,其優秀特質將融入未來的模型開發中。

核心亮點:頂尖性能與超大容量

GPT-4.1 系列的核心優勢體現在以下幾個方面:

- 頂尖性能表現:OpenAI 在多個關鍵基準測試中展示了 GPT-4.1 相較於 GPT-4o 和 GPT-4.5 的顯著提升,特別是在程式編碼、指令遵循和多模態理解等領域。

- 百萬級 Token 上下文:全系列模型均支援高達 100 萬 Token 的上下文長度,遠超 GPT-4o 的 12.8 萬。這相當於能一次處理超過 75 萬個單字或數個大型程式碼庫,極大地擴展了處理長文件、複雜推理和大型專案的可能性。

- 更低的延遲與成本:相較於前代,GPT-4.1 和 GPT-4.1 mini 在提供更強性能的同時,也降低了 API 呼叫的延遲。價格方面,GPT-4.1 的 API 定價比 GPT-4o 低約 26%,而 GPT-4.1 mini 更是大幅降低了成本。

- 更新的知識庫:模型知識截止日期更新至 2024 年 6 月,能理解和回應此日期之前的事件和資訊。

性能基準測試表現 (詳細數據)

為了具體展現 GPT-4.1 的性能優勢,OpenAI 公布了其在多項標準化測試中的詳細表現,涵蓋學術知識、程式編碼、指令遵循、長上下文處理、視覺理解及函數呼叫等多個面向。以下將依類別呈現詳細數據:

學術知識 (Academic Knowledge)

評估模型在標準學術測驗上的表現。

| Category | GPT-4.1 (%) | GPT-4.1 mini (%) | GPT-4.1 nano (%) | GPT-4o (2024-11-20) (%) | GPT-4o mini (%) | OpenAI o1 (high) (%) | OpenAI o3-mini (high) (%) | GPT-4.5 (%) |

|---|---|---|---|---|---|---|---|---|

| AIME ‘24 | 48.1 | 49.6 | 29.4 | 13.1 | 8.6 | 74.3 | 87.3 | 36.7 |

| GPQA Diamond¹ | 66.3 | 65.0 | 50.3 | 46.0 | 40.2 | 75.7 | 77.2 | 69.5 |

| MMLU | 90.2 | 87.5 | 80.1 | 85.7 | 82.0 | 91.8 | 86.9 | 90.8 |

| Multilingual MMLU | 87.3 | 78.5 | 66.9 | 81.4 | 70.5 | 87.7 | 80.7 | 85.1 |

¹ 註:GPQA 測試使用特定模型提取答案而非正則表達式。對 GPT-4.1 影響 <1% (不顯著),但對 GPT-4o 提取方式顯著提升分數 (約 46% -> 54%)。

程式編碼評估 (Coding Evals)

衡量模型在程式碼生成、修復和理解方面的能力。

| Category | GPT-4.1 | GPT-4.1 mini | GPT-4.1 nano | GPT-4o (2024-11-20) | GPT-4o mini | OpenAI o1 (high) | OpenAI o3-mini (high) | GPT-4.5 |

|---|---|---|---|---|---|---|---|---|

| SWE-bench Verified² | 54.6% | 23.6% | - | 33.2% | 8.7% | 41.0% | 49.3% | 38.0% |

| SWE-Lancer | $176K (35.1%) | $165K (33.0%) | $77K (15.3%) | $163K (32.6%) | $116K (23.1%) | $160K (32.1%) | $90K (18.0%) | $186K (37.3%) |

| SWE-Lancer (IC-Diamond) | $34K (14.4%) | $31K (13.1%) | $9K (3.7%) | $29K (12.4%) | $11K (4.8%) | $29K (9.7%) | $17K (7.4%) | $41K (17.4%) |

| Aider’s polyglot whole | 51.6% | 34.7% | 9.8% | 30.7% | 3.6% | 64.6% | 66.7% | - |

| Aider’s polyglot diff | 52.9% | 31.6% | 6.2% | 18.2% | 2.7% | 61.7% | 60.4% | 44.9% |

² 註:排除了 23/500 個無法在基礎設施上運行的問題。詳細列表見原圖註釋。

指令遵循評估 (Instruction Following Eval)

測試模型理解並準確執行複雜指令的能力。

| Category | GPT-4.1 (%) | GPT-4.1 mini (%) | GPT-4.1 nano (%) | GPT-4o (2024-11-20) (%) | GPT-4o mini (%) | OpenAI o1 (high) (%) | OpenAI o3-mini (high) (%) | GPT-4.5 (%) |

|---|---|---|---|---|---|---|---|---|

| Internal API instruction following (hard) | 49.1 | 45.1 | 31.6 | 29.2 | 27.2 | 51.3 | 50.0 | 54.0 |

| MultiChallenge | 38.3 | 35.8 | 15.0 | 27.8 | 20.3 | 44.9 | 39.9 | 43.8 |

| MultiChallenge (o3-mini grader)³ | 46.2 | 42.2 | 31.1 | 39.9 | 25.6 | 52.9 | 50.2 | 50.1 |

| COLLIE | 65.8 | 54.6 | 42.5 | 50.2 | 52.7 | 95.3 | 98.7 | 72.3 |

| IFEval | 87.4 | 84.1 | 74.5 | 81.0 | 78.4 | 92.2 | 93.9 | 88.2 |

| Multi-IF | 70.8 | 67.0 | 57.2 | 60.9 | 57.9 | 77.9 | 79.5 | 70.8 |

³ 註:預設的 MultiChallenge 評分器 (GPT-4o) 會頻繁誤判模型回應。改用推理模型 (如 o3-mini) 評分可顯著提高評分準確性。為保持一致性,同時發布兩種評分結果。

長上下文評估 (Long Context Evals)

檢驗模型在處理和理解長文本輸入方面的表現,特別是利用其百萬 Token 上下文窗口的能力。

| Category | GPT-4.1 (%) | GPT-4.1 mini (%) | GPT-4.1 nano (%) | GPT-4o (2024-11-20) (%) | GPT-4o mini (%) | OpenAI o1 (high) (%) | OpenAI o3-mini (high) (%) | GPT-4.5 (%) |

|---|---|---|---|---|---|---|---|---|

| OpenAI-MRCR: 2 needle128k | 57.2 | 47.2 | 36.6 | 31.9 | 24.5 | 22.1 | 18.7 | 38.5 |

| OpenAI-MRCR: 2 needle 1M | 46.3 | 33.3 | 12.0 | - | - | - | - | - |

| Graphwalks bfs <128k | 61.7 | 61.7 | 25.0 | 41.7 | 29.0 | 62.0 | 51.0 | 72.3 |

| Graphwalks bfs >128k | 19.0 | 15.0 | 2.9 | - | - | - | - | - |

| Graphwalks parents <128k | 58.0 | 60.5 | 9.4 | 35.4 | 12.6 | 50.9 | 58.3 | 72.6 |

| Graphwalks parents >128k | 25.0 | 11.0 | 5.6 | - | - | - | - | - |

註:1M Token 測試及 >128k 的 Graphwalks 測試僅適用於支援超長上下文的模型。

視覺評估 (Vision Eval)

評估模型理解和分析圖像內容的能力。

| Category | GPT-4.1 (%) | GPT-4.1 mini (%) | GPT-4.1 nano (%) | GPT-4o (2024-11-20) (%) | GPT-4o mini (%) | OpenAI o1 (high) (%) | OpenAI o3-mini (high) (%) | GPT-4.5 (%) |

|---|---|---|---|---|---|---|---|---|

| MMMU | 74.8 | 72.7 | 55.4 | 68.7 | 56.3 | 77.6 | - | 75.2 |

| MathVista | 72.2 | 73.1 | 56.2 | 61.4 | 56.5 | 71.8 | - | 72.3 |

| CharXiv-R | 56.7 | 56.8 | 40.5 | 52.7 | 36.8 | 55.1 | - | 55.4 |

| CharXiv-D | 87.9 | 88.4 | 73.9 | 85.3 | 76.6 | 88.9 | - | 90.0 |

函數呼叫評估 (Function Calling Eval)

測試模型根據指令準確呼叫外部工具或 API 的能力。

| Category | GPT-4.1 (%) | GPT-4.1 mini (%) | GPT-4.1 nano (%) | GPT-4o (2024-11-20) (%) | GPT-4o mini (%) | OpenAI o1 (high) (%) | OpenAI o3-mini (high) (%) | GPT-4.5 (%) |

|---|---|---|---|---|---|---|---|---|

| ComplexFuncBench | 65.5 | 49.3 | 0.6 | 66.5 | 38.6 | 47.6 | 17.6 | 63.0 |

| Taubench airline⁴ | 49.4 | 36.0 | 14.0 | 42.8 | 22.0 | 50.0 | 32.4 | 50.0 |

| Taubench retail⁴⁵ | 68.0 (73.6) | 55.8 (65.4) | 22.6 (23.5) | 60.3 | 44.0 | 70.8 | 57.6 | 68.4 |

⁴ 註:Taubench 數值為 5 次運行的平均值,以減少變異性,且運行時未使用自定義工具或提示。 ⁵ 註:括號內的數字是使用 GPT-4.1 作為用戶模型(而非 GPT-4o)時的 Taubench 結果。由於 GPT-4.1 指令遵循能力更強,作為用戶模型時表現更好,產生更成功的軌跡,這被認為更能代表評估模型的真實性能。

從以上詳細數據可以看出,GPT-4.1 在多數評估項目中處於領先地位,尤其是在程式碼相關任務、指令遵循、多語言理解以及利用其超長上下文窗口的測試中。GPT-4.1 mini 作為中階模型,也在許多方面超越了前代旗艦 GPT-4o,展現了極高的性價比。

模型分級與定價策略

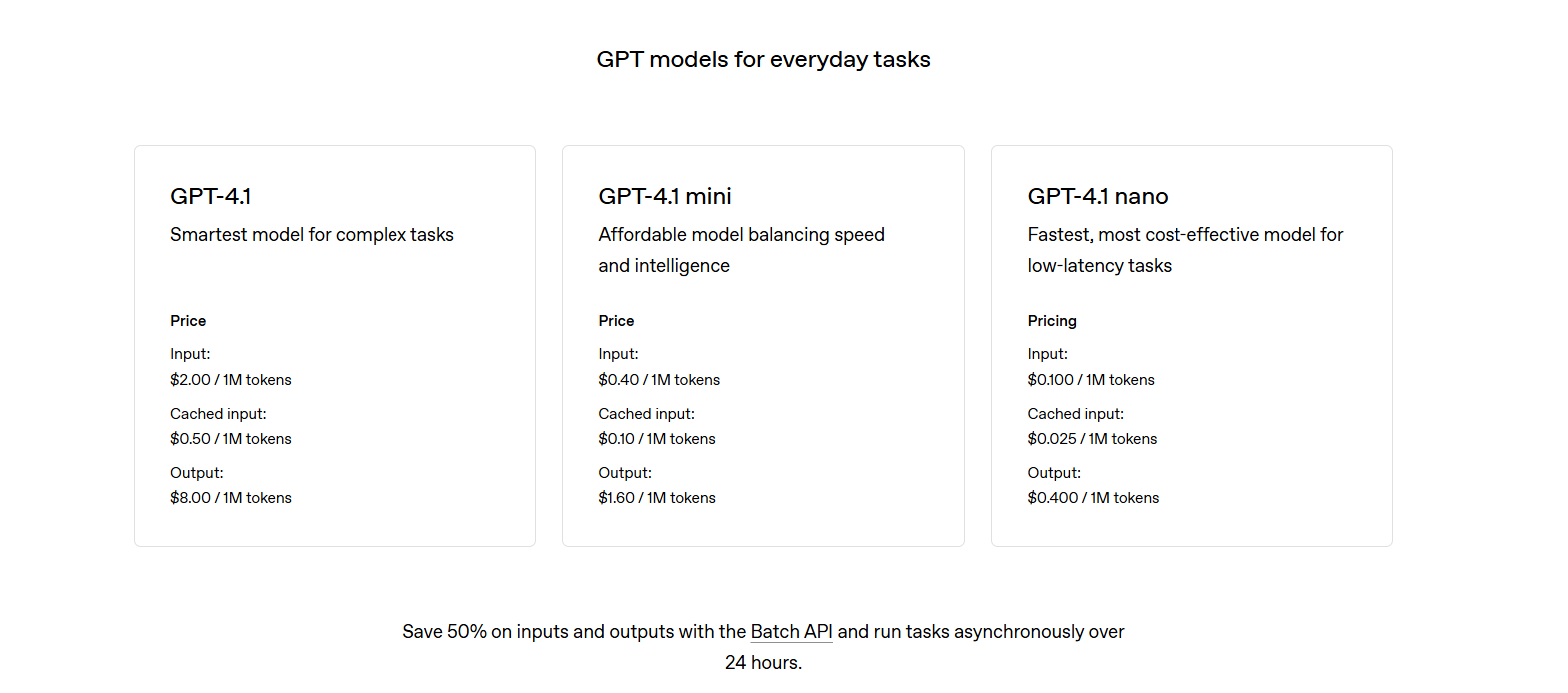

為了滿足不同開發需求和預算考量,GPT-4.1 系列提供了三種不同規模的模型:

-

GPT-4.1:

- 定位:能力最強,適用於複雜任務、企業級 AI 代理、高精度 AI 助理、科學研究等。

- 價格:輸入 $2.00 / 百萬 Token,輸出 $8.00 / 百萬 Token。

-

GPT-4.1 mini:

- 定位:中階模型,性能優越 (部分超越 GPT-4o),延遲減半,成本降低 83%。適用於中大型應用、快速原型設計、自動化客服等。

- 價格:輸入 $0.40 / 百萬 Token,輸出 $1.60 / 百萬 Token。

-

GPT-4.1 nano:

- 定位:最快、最經濟,適用於邏輯明確、結構化的簡單任務 (如分類、摘要、自動完成),適合移動端或邊緣運算。仍支援 100 萬 Token 上下文。

- 價格:輸入 $0.10 / 百萬 Token,輸出 $0.40 / 百萬 Token。

API 專供策略與 GPT-4.5 的未來

將 GPT-4.1 系列設定為 API 限定,顯示 OpenAI 可能希望將其最前沿、面向專業開發者的能力與大眾化的 ChatGPT 服務做出區隔。這使得開發者能充分利用其強化的編碼和長上下文處理能力,打造更具突破性的應用。

至於 GPT-4.5 的退場,OpenAI 解釋其作為研究預覽版已達成目的,從開發者回饋中學習良多,並計劃將其受讚賞的特質(如創造力、寫作品質、幽默感)融入未來模型的開發。開發者需在 2025 年 7 月 14 日前完成從 GPT-4.5 預覽版的遷移。

總結

OpenAI GPT-4.1 系列的發布,無疑為 AI 開發領域注入了新的動能。其更強的性能、前所未有的百萬級 Token 容量以及更專業化的 API 定位,為開發者提供了更強大的創新工具,尤其在處理大型程式碼專案、深度分析長篇報告、建構複雜 AI 代理等方面,開啟了新的想像空間。隨著開發者開始探索和應用 GPT-4.1 的能力,我們可以期待更多令人驚豔的 AI 應用誕生。